Docker高级篇

Docker高级篇·

第 九 章 Docker复杂安装详说·

1.1 安装MySQL主从复制·

1.1.1 主从复制原理·

1. 数据库主从概念、优点、用途·

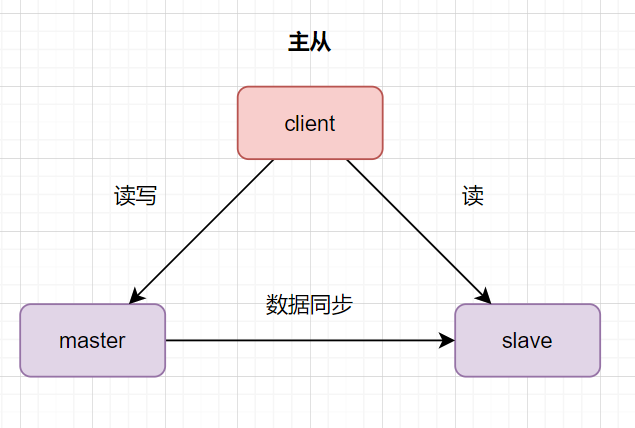

主从数据库是什么意思呢,主是主库的意思,从是从库的意思。数据库主库对外提供读写的操作,从库对外提供读的操作。 数据库为什么需要主从架构呢?

数据库为什么需要主从架构呢?

- 高可用,实时灾备,用于故障切换。比如主库挂了,可以切从库。

- 读写分离,提供查询服务,减少主库压力,提升性能

- 备份数据,避免影响业务。

2. 数据库主从复制原理·

主从复制原理,简言之,分三步曲进行:

- 主数据库有个

bin log二进制文件,记录了所有增删改SQL语句。(binlog线程) - 从数据库把主数据库的

bin log文件的SQL语句复制到自己的中继日志relay log(io线程) - 从数据库的

relay log重做日志文件,再执行一次这些sql语句。(sql执行线程)

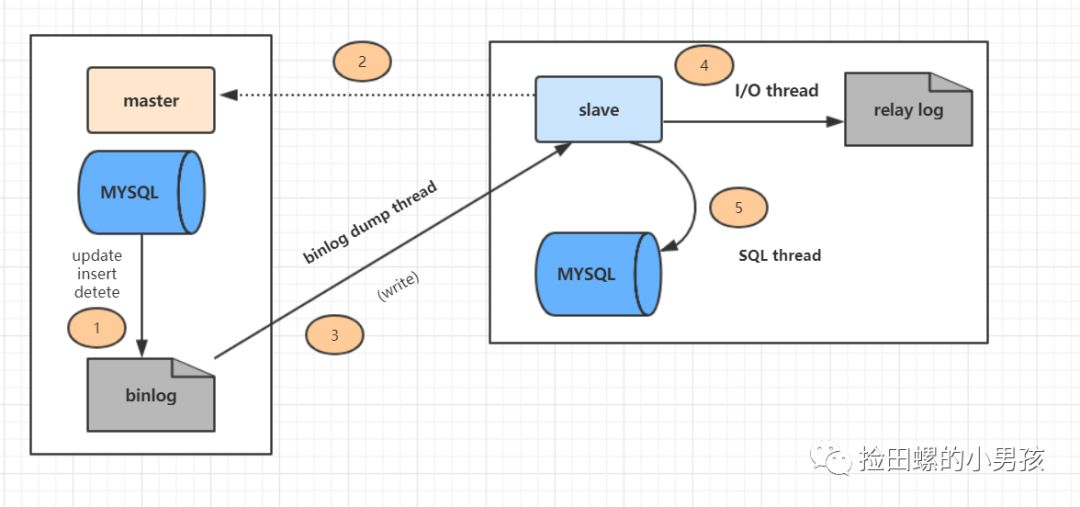

详细的主从复制过程如图:

上图主从复制过程分了五个步骤进行:

- 主库的更新SQL(update、insert、delete)被写到binlog

- 从库发起连接,连接到主库。

- 此时主库创建一个

binlog dump thread,把bin log的内容发送到从库。 - 从库启动之后,创建一个

I/O线程,读取主库传过来的bin log内容并写到relay log - 从库还会创建一个SQL线程,从

relay log里面读取内容,从ExecMasterLog_Pos位置开始执行读取到的更新事件,将更新内容写入到slave的db

3.主主、主从、主备的区别·

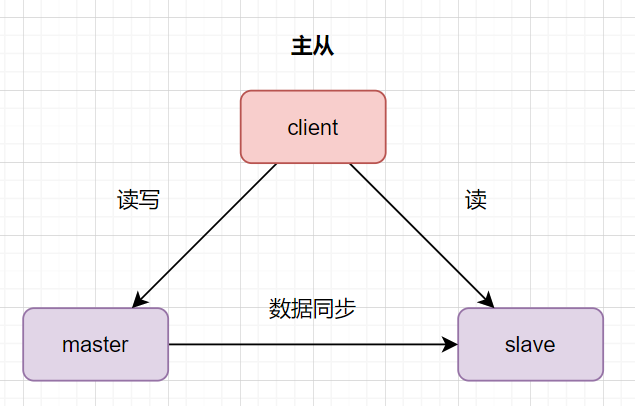

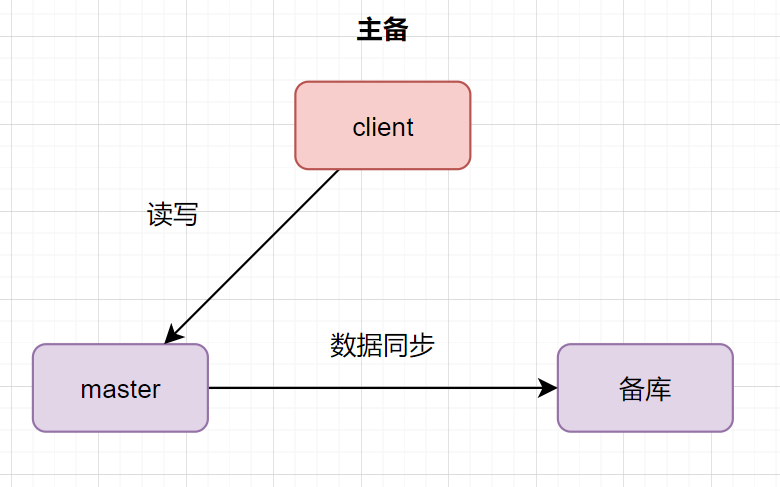

数据库主主:两台都是主数据库,同时对外提供读写操作。客户端访问任意一台。数据存在双向同步。 数据库主从:一台是主数据库,同时对外提供读写操作。一台是从数据库,对外提供读的操作。数据从主库同步到从库。

数据库主从:一台是主数据库,同时对外提供读写操作。一台是从数据库,对外提供读的操作。数据从主库同步到从库。

从库和备库,就是slave库功能不同因此叫法不一样而已。一般slave库都会对外提供读的功能的,因此,大家日常听得最多的就是主从。

4.MySQL是怎样保证主从一致的·

我们学习数据库的主从复制原理后,了解到从库拿到并执行主库的binlog日志,就可以保持数据与主库一致了。这是为什么呢?哪些情况会导致不一致呢?

4.1长链接·

主库和从库在同步数据的过程中断怎么办呢,数据不就会丢失了嘛。因此主库与从库之间维持了一个长链接,主库内部有一个线程,专门服务于从库这个长链接。

4.2binlog格式·

binlog 日志有三种格式,分别是 statement,row 和 mixed。

如果是 statement 格式,binlog 记录的是 SQL的原文,如果主库和从库选的索引不一致,可能会导致主库不一致。我们来分析一下。假设主库执行删除这个SQL(其中,a 和 create_time 都会有索引)如下:

1 | delete from t where a > '666' and create_time < '2022-03-02' limit 1; |

我们知道,数据库选择了 a 索引和选择 create_time 索引,最后 limit 1 出来的数据一般是不一样的。所以就会存在这种情况:在 binlog = statement 格式时,主库在执行这条SQL时,使用的是索引a,而从库在执行这条SQL时,使用了索引 create_time。最后主从数据不一致了。

如何解决这个问题呢?

可以把binlog格式修改为 row。row 格式的 binlog 日志,记录的不是 SQL原文,而是两个 event: Table_map 和 Delete_rows。Table_map event 说明要操作的表,Delete_rows event 用于定义要删除的行为,记录删除的具体行数。row 格式的binlog记录的就是要删除的主键ID信息,因此不会出现主从不一致的问题。

但是如果SQL删除10万行数据,使用row格式就会很占空间的,10万条数据都在 binlog 里面,写 binlog 的时候也很耗IO。但是 statement 格式的binlog可能会导致数据不一致,因此设计MySQL的大叔想了一个折中的方案,mixed 格式的 binlog。所谓的 mixed格式其实就是 row 和 statement 格式混合使用,当 MySQL 判断可能数据不一致时,就用 row 格式,否则使用 statement 格式。

5.数据库主从延迟的原因与解决方案·

主从延迟是怎样定义的呢?与主从数据同步相关的时间点有三个

- 主库执行完一个事务,写入binlog,我们把这个时刻记为

T1; - 主库同步数据给从库,从库接受完这个binlog的时刻,记录为

T2; - 从库执行完这个事务,这个时刻记录为

T3。

所谓主从延迟,其实就是指同一个事务,在从库执行完的时间和在主库执行完的时间差值,即 T3-T1。

哪些情况会导致主从延迟呢?

- 如果从库所在的机器比主库的机器性能差,会导致主从延迟,这种情况比较好解决,只需选择主从库一样规格的机器就好。

- 如果从库的压力大,也会导致主从延迟。比如主库直接影响业务,大家可能使用会比较克制,因此一般查询都打到从库了,结果导致从库查询消耗大量CPU,影响同步速度,最后导致主从延迟。这种情况的话,可以搞一主多从架构,即多接几个从库分摊读的压力。另外,还可以把binlog接入到Hadoop这类系统,让它们提供查询的能力。

- 大事务也会导致主从延迟。如果一个事务执行就要10分钟,那么主库执行完后,给到从库执行,最后这个事务可能就会导致从库延迟10分钟啦。日常开发中,我们为什么特别强调,不要一次性delete太多SQL,需要分批进行,其实也是为了避免大事务。另外,大表的DDL语句,也会导致大事务,大家日常开发关注一下哈。

- 网络延迟也会导致主从延迟,这种情况你只能优化你的网络啦,比如带宽20M升级到100M类似意思等。

- 如果从数据库过多也会导致主从延迟,因此要避免复制的从节点数量过多。从库数据一般以3-5个为宜。

- 低版本的MySQL只支持单线程复制,如果主库并发高,来不及传送到从库,就会导致延迟。可以换用更高版本的Mysql,可以支持多线程复制。

6.聊聊数据的库高可用方案·

6.1双机主备高可用·

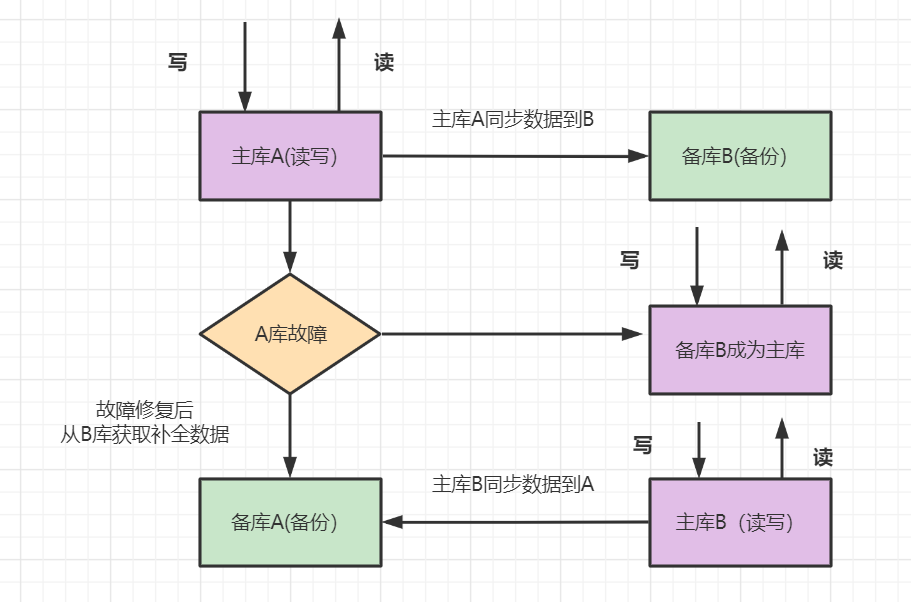

- 架构描述:两台机器A和B,A为主库,负责读写,B为备库,只备份数据。如果A库发生故障,B库成为主库负责读写。修复故障后,A成为备库,主库B同步数据到备库A

- 优点:一个机器故障了可以自动切换,操作比较简单。

- 缺点:只有一个库在工作,读写压力大,未能实现读写分离,并发也有一定限制

6.2一主一从·

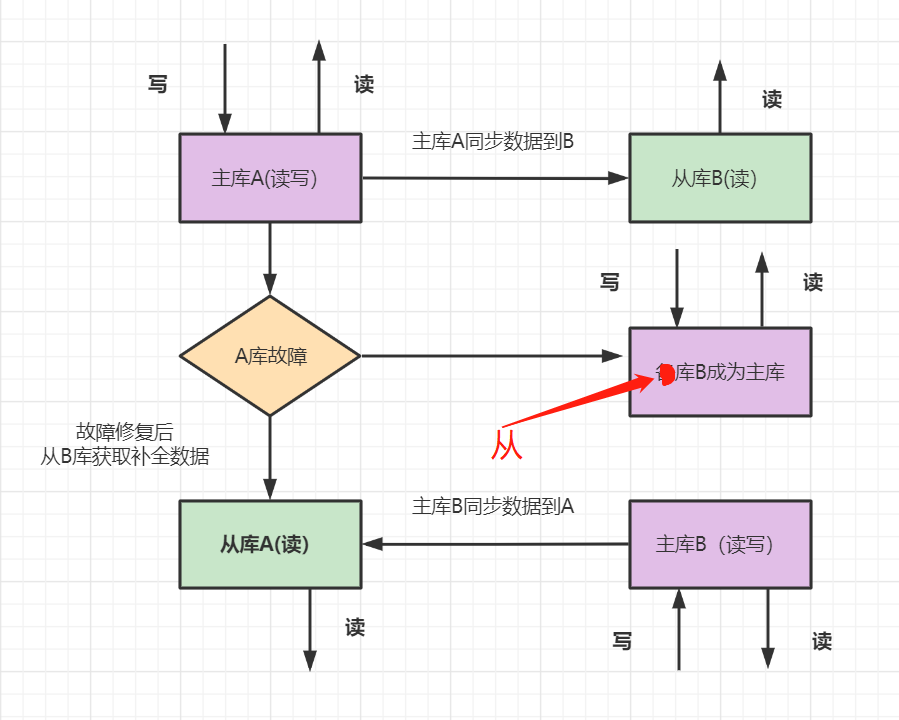

- 架构描述: 两台机器A和B,A为主库,负责读写,B为从库,负责读数据。如果A库发生故障,B库成为主库负责读写。修复故障后,A成为从库,主库B同步数据到从库A。

- 优点:从库支持读,分担了主库的压力,提升了并发度。一个机器故障了可以自动切换,操作比较简单。

- 缺点:一台从库,并发支持还是不够,并且一共两台机器,还是存在同时故障的机率,不够高可用。

6.3一主多从·

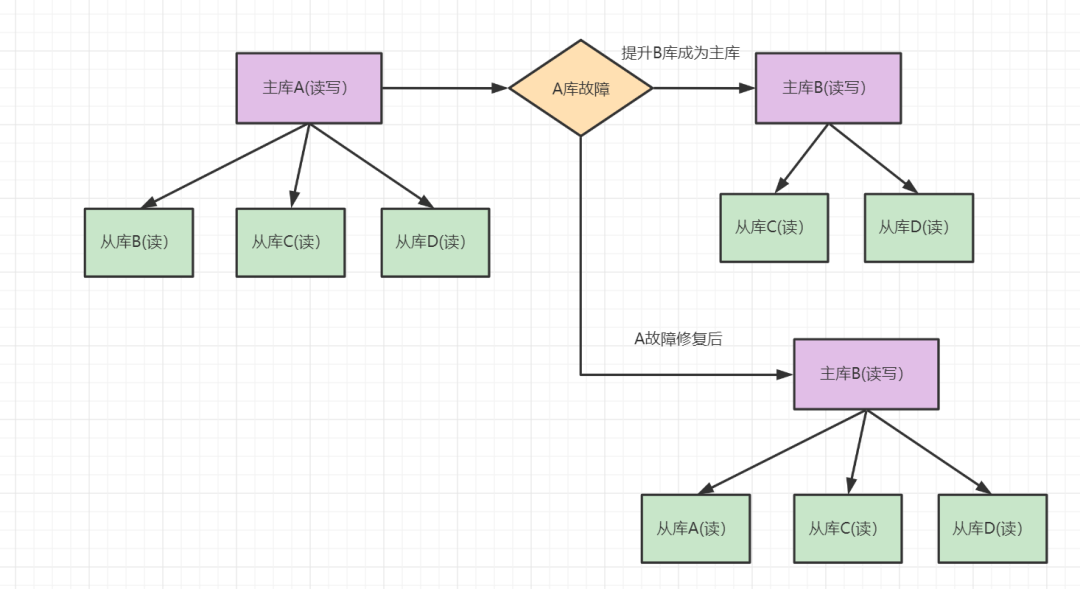

- 架构描述: 一台主库多台从库,A为主库,负责读写,B、C、D为从库,负责读数据。如果A库发生故障,B库成为主库负责读写,C、D负责读。修复故障后,A也成为从库,主库B同步数据到从库A。

- 优点:多个从库支持读,分担了主库的压力,明显提升了读的并发度。

- 缺点:只有台主机写,因此写的并发度不高

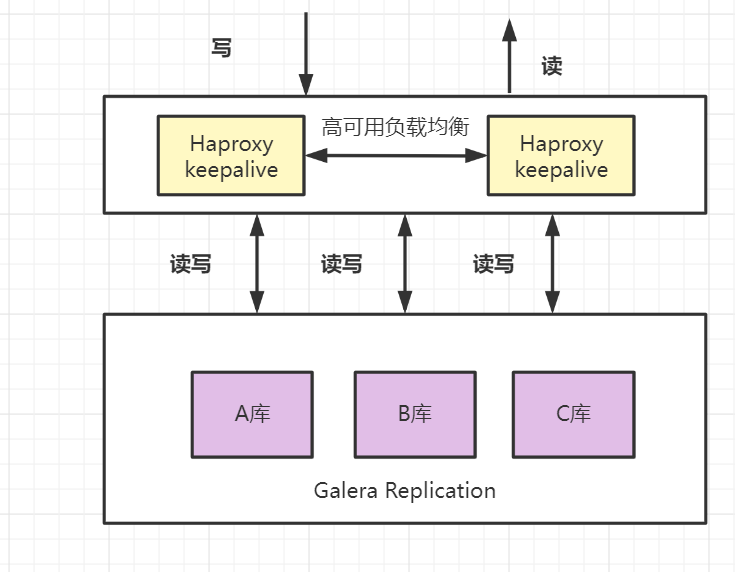

6.4MariaDB同步多主机集群·

- 架构描述:有代理层实现负载均衡,多个数据库可以同时进行读写操作;各个数据库之间可以通过

Galera Replication方法进行数据同步,每个库理论上数据是完全一致的。 - 优点:读写的并发度都明显提升,可以任意节点读写,可以自动剔除故障节点,具有较高的可靠性。

- 缺点:数据量不支持特别大。要避免大事务卡死,如果集群节点一个变慢,其他节点也会跟着变慢。

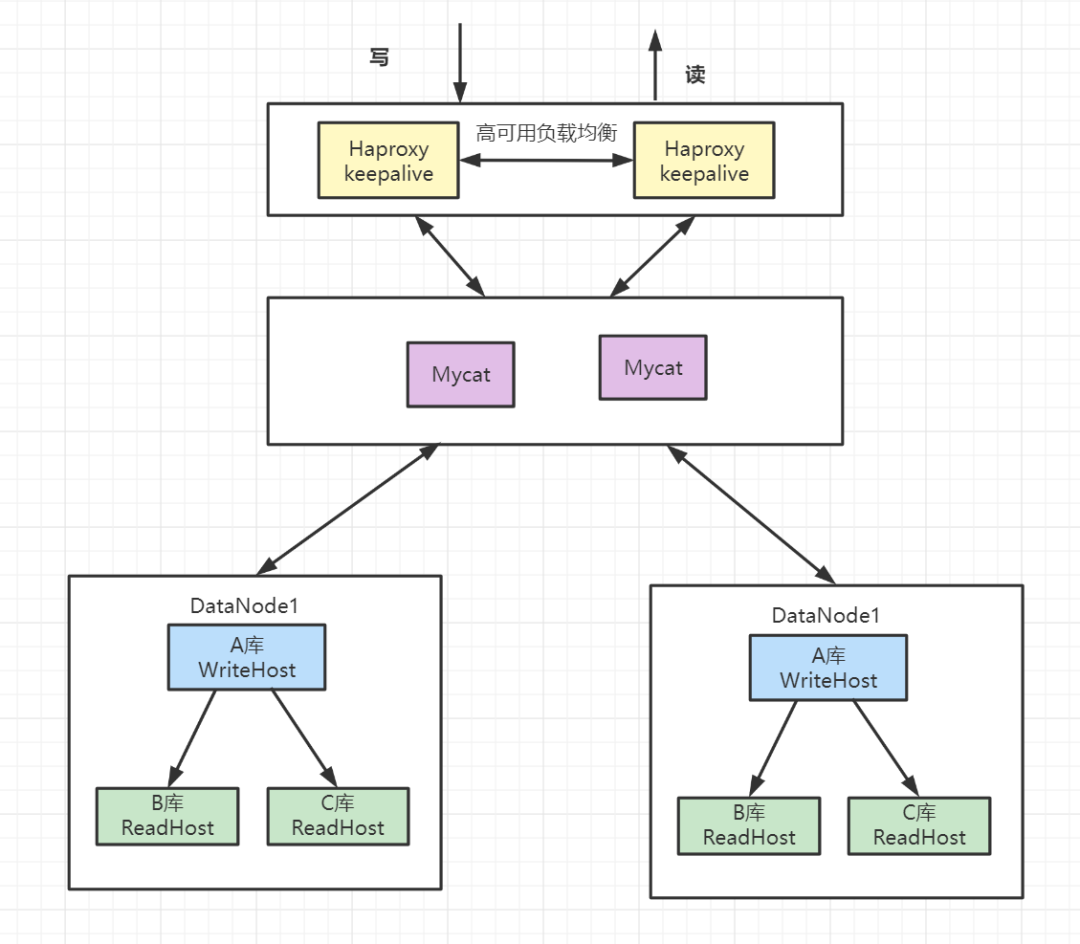

6.5数据库中间件·

- 架构描述:mycat分片存储,每个分片配置一主多从的集群。

- 优点:解决高并发高数据量的高可用方案

- 缺点:维护成本比较大。

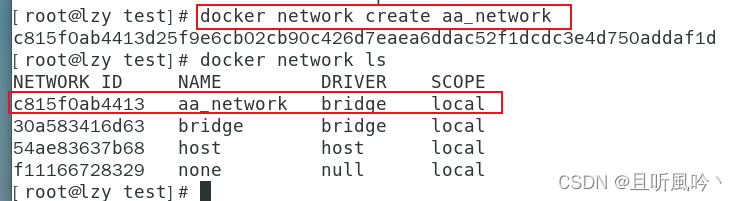

1.1.2 主从搭建步骤·

1、启动主节点3307·

1 | docker run -p 3307:3306 --name mysql-master \ |

2、在主节点conf目录下编辑配置文件my.cnf·

master节点,进入/mydata/mysql-master/conf目录下新建或编辑my.cnf

1 | [mysqld] |

3、修改完配置后重启master实例·

1 | docker restart mysql-master |

4、进入mysql-master容器·

1 | docker exec -it mysql-master /bin/bash |

5、master容器实例内创建数据同步用户·

1 | CREATE USER 'slave'@'%' IDENTIFIED BY '123456'; |

6、新建从节点3308·

1 | docker run -p 3308:3306 --name mysql-slave \ |

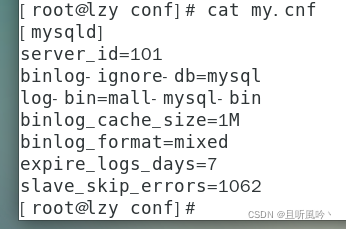

7、在从节点conf目录下编辑配置文件my.cnf·

1 | [mysqld] |

8、修改完配置后重启slave实例·

1 | docker restart mysql-slave |

9、在主数据库中查看主从同步状态·

1 | show master status; |

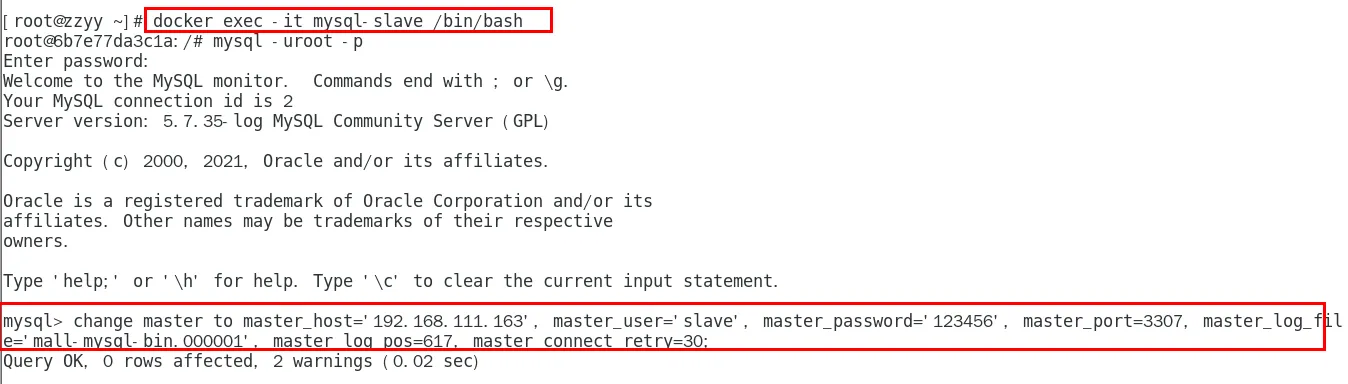

10、进入mysql-slave容器·

1 | docker exec -it mysql-slave /bin/bash |

11、在从数据库中配置主从复制·

1 | change master to master_host='宿主机ip', master_user='slave', master_password='123456', master_port=3307, master_log_file='mall-mysql-bin.000001', master_log_pos=617, master_connect_retry=30; |

主从复制命令参数说明

master_host:主数据库的IP地址; master_port:主数据库的运行端口; master_user:在主数据库创建的用于同步数据的用户账号; master_password:在主数据库创建的用于同步数据的用户密码; master_log_file:指定从数据库要复制数据的日志文件,通过查看主数据的状态,获取File参数; master_log_pos:指定从数据库从哪个位置开始复制数据,通过查看主数据的状态,获取Position参数; master_connect_retry:连接失败重试的时间间隔,单位为秒。

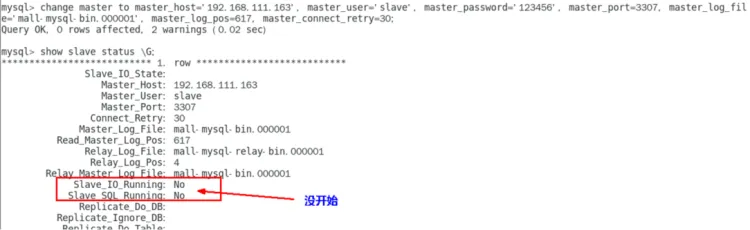

12、在从数据库中查看主从同步状态·

1 | show slave status \G; |

slave_io_running 和 slave_sql_running 为 NO

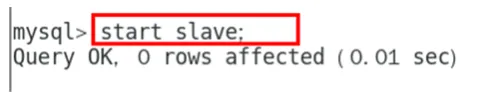

13、在从数据库中开启主从同步·

1 | start slave; |

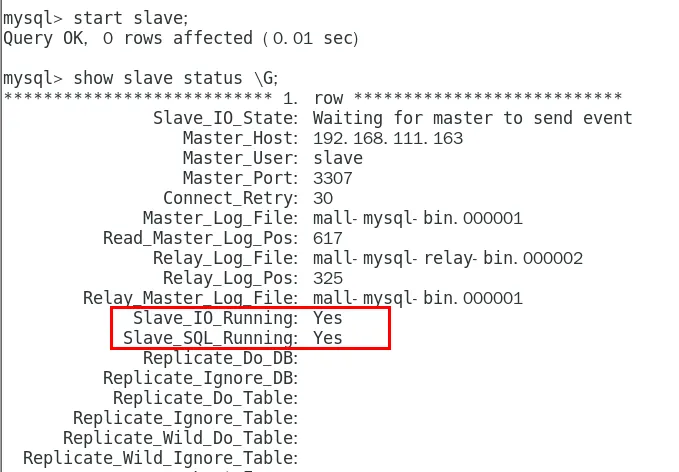

14、查看从数据库同步状态·

slave_io_running 和 slave_sql_running 为 NO变为 YES

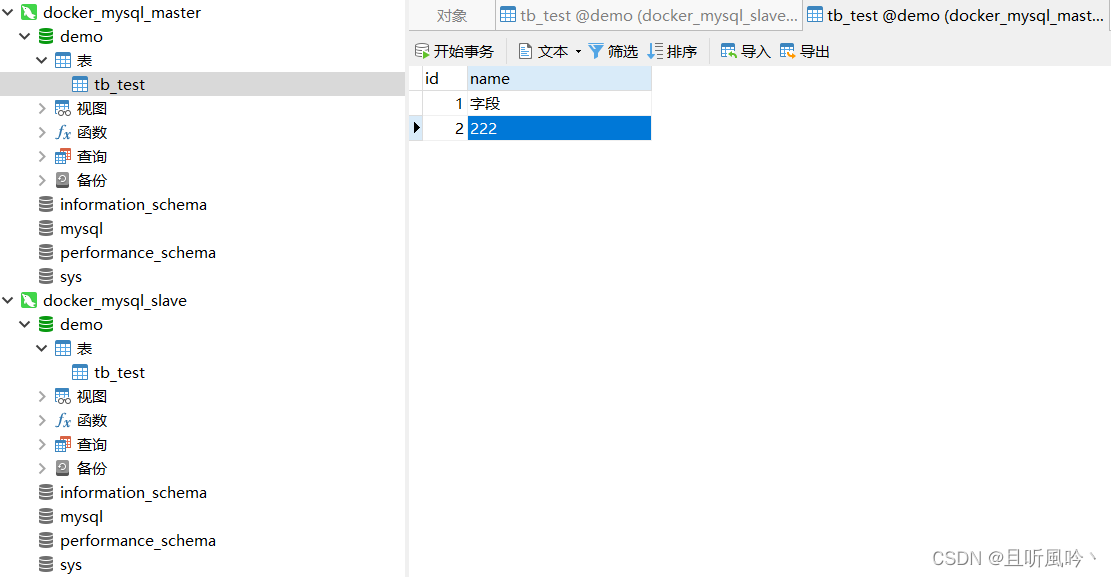

15、测试主从同步·

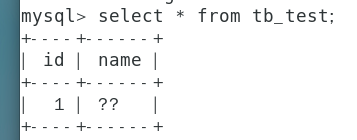

操作数据库工具连接主库,并写入记录,切换到从库发现对应数据已经同步。

a. 主机新建库-使用库-新建表-插入数据,ok b. 从机使用库-查看记录,ok

注意·

关于字符编码

经过测试,如果不按照初级篇修改对应编码,在centos上会出现乱码

所以我这里配置文件根据初级篇做了修改,完全版本如下所示。

1 | [client] |

1.2、安装redis集群·

1.2.1、亿级数据缓存·

1~2亿条数据需要缓存,请问如何设计这个存储案例?回答:单机单台100%不可能,肯定是分布式存储,用redis如何落地?上述问题阿里P6~P7工程案例和场景设计类必考题目, 一般业界有3种解决方案

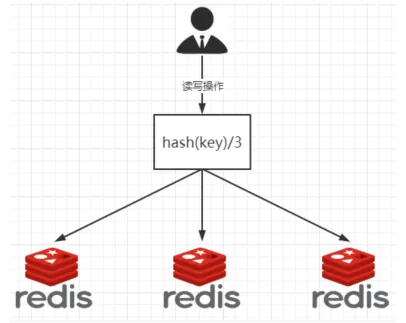

- 哈希取余分区

2亿条记录就是2亿个k,v,我们单机不行必须要分布式多机,假设有3台机器构成一个集群,用户每次读写操作都是根据公式:

hash(key) % N个机器台数,计算出哈希值,用来决定数据映射到哪一个节点上。

优点:

简单粗暴,直接有效,只需要预估好数据规划好节点,例如3台、8台、10台,就能保证一段时间的数据支撑。使用Hash算法让固定的一部分请求落到同一台服务器上,这样每台服务器固定处理一部分请求(并维护这些请求的信息),起到负载均衡+分而治之的作用。

缺点:

原来规划好的节点,进行扩容或者缩容就比较麻烦了额,不管扩缩,每次数据变动导致节点有变动,映射关系需要重新进行计算,在服务器个数固定不变时没有问题,如果需要弹性扩容或故障停机的情况下,原来的取模公式就会发生变化:Hash(key)/3会变成Hash(key) /?。此时地址经过取余运算的结果将发生很大变化,根据公式获取的服务器也会变得不可控。

某个redis机器宕机了,由于台数数量变化,会导致hash取余全部数据重新洗牌。

一致性哈希算法分区

- 是什么

一致性Hash算法背景 一致性哈希算法在1997年由麻省理工学院中提出的,设计目标是为了解决分布式缓存数据变动和映射问题,某个机器宕机了,分母数量改变了,自然取余数不OK了。

能干嘛

提出一致性Hash解决方案。 目的是当服务器个数发生变动时, 尽量减少影响客户端到服务器的映射关系

3大步骤

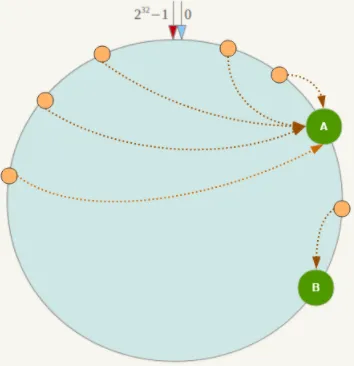

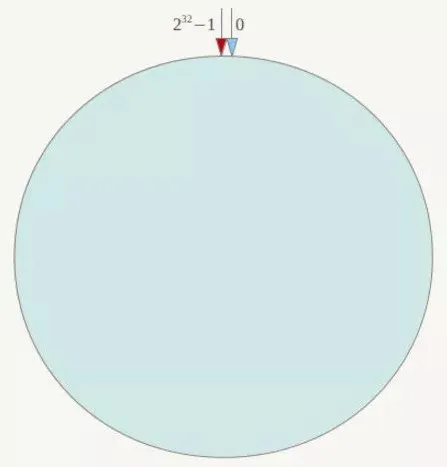

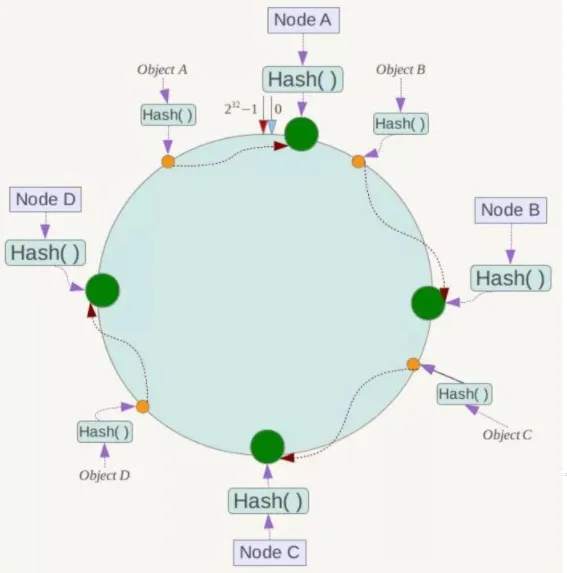

- 算法构建一致性哈希环

一致性哈希环一致性哈希算法必然有个hash函数并按照算法产生hash值,这个算法的所有可能哈希值会构成一个全量集,这个集合可以成为一个hash空间[0,2^32-1],这个是一个线性空间,但是在算法中,我们通过适当的逻辑控制将它首尾相连(0 = 2^32),这样让它逻辑上形成了一个环形空间。它也是按照使用取模的方法,前面笔记介绍的节点取模法是对节点(服务器)的数量进行取模。而一致性Hash算法是对232取模,简单来说,一致性Hash算法将整个哈希值空间组织成一个虚拟的圆环,如假设某哈希函数H的值空间为0-232-1(即哈希值是一个32位无符号整形),整个哈希环如下图:整个空间按顺时针方向组织,圆环的正上方的点代表0,0点右侧的第一个点代表1,以此类推,2、3、4、……直到232-1,也就是说0点左侧的第一个点代表232-1, 0和232-1在零点中方向重合,我们把这个由232个点组成的圆环称为Hash环。

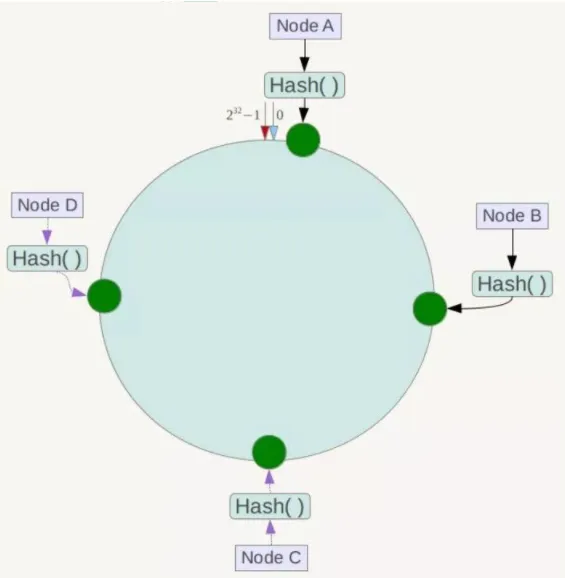

- 服务器IP节点映射

节点映射将集群中各个IP节点映射到环上的某一个位置。将各个服务器使用Hash进行一个哈希,具体可以选择服务器的IP或主机名作为关键字进行哈希,这样每台机器就能确定其在哈希环上的位置。假如4个节点NodeA、B、C、D,经过IP地址的哈希函数计算(hash(ip)),使用IP地址哈希后在环空间的位置如下:

- key落到服务器的落键规则

当我们需要存储一个kv键值对时,首先计算key的hash值,hash(key),将这个key使用相同的函数Hash计算出哈希值并确定此数据在环上的位置,从此位置沿环顺时针“行走”,第一台遇到的服务器就是其应该定位到的服务器,并将该键值对存储在该节点上。如我们有Object A、Object B、Object C、Object D四个数据对象,经过哈希计算后,在环空间上的位置如下:根据一致性Hash算法,数据A会被定为到Node A上,B被定为到Node B上,C被定为到Node C上,D被定为到Node D上。

优点

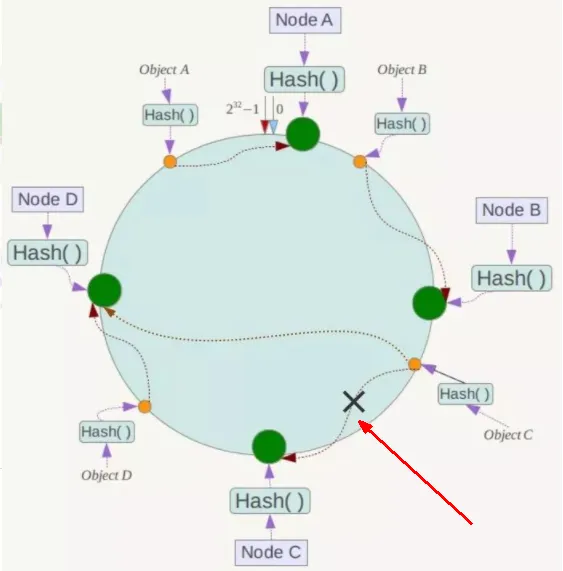

- 一致性哈希算法的容错性

容错性假设Node C宕机,可以看到此时对象A、B、D不会受到影响,只有C对象被重定位到Node D。一般的,在一致性Hash算法中,如果一台服务器不可用,则受影响的数据仅仅是此服务器到其环空间中前一台服务器(即沿着逆时针方向行走遇到的第一台服务器)之间数据,其它不会受到影响。简单说,就是C挂了,受到影响的只是B、C之间的数据,并且这些数据会转移到D进行存储。

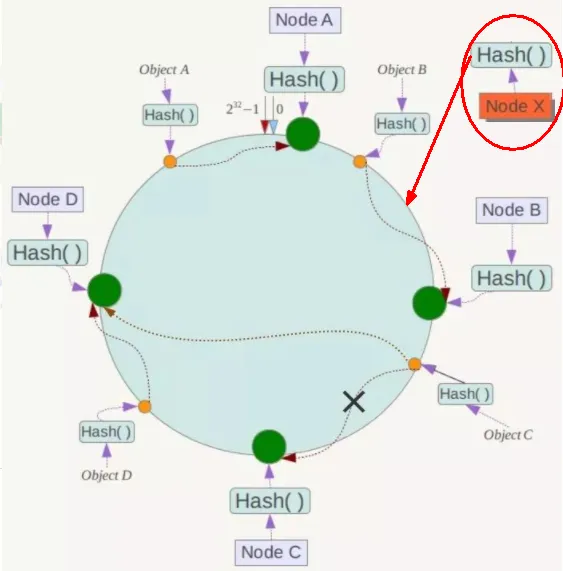

- 一致性哈希算法的扩展性

数据量增加了,需要增加一台节点NodeX,X的位置在A和B之间,那收到影响的也就是A到X之间的数据,重新把A到X的数据录入到X上即可,不会导致hash取余全部数据重新洗牌。

缺点

一致性哈希算法的数据倾斜问题

Hash环的数据倾斜问题一致性Hash算法在服务节点太少时,容易因为节点分布不均匀而造成数据倾斜(被缓存的对象大部分集中缓存在某一台服务器上)问题,例如系统中只有两台服务器:

- 小总结

为了在节点数目发生改变时尽可能少的迁移数据将所有的存储节点排列在收尾相接的Hash环上,每个key在计算Hash后会顺时针找到临近的存储节点存放。而当有节点加入或退出时仅影响该节点在Hash环上顺时针相邻的后续节点。

优点加入和删除节点只影响哈希环中顺时针方向的相邻的节点,对其他节点无影响。缺点数据的分布和节点的位置有关,因为这些节点不是均匀的分布在哈希环上的,所以数据在进行存储时达不到均匀分布的效果。

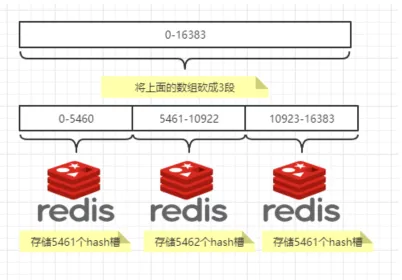

哈希槽分区

- 是什么

1 为什么出现

哈希槽实质就是一个数组,数组[0,2^14 -1]形成hash slot空间。 2 能干什么解决均匀分配的问题,在数据和节点之间又加入了一层,把这层称为哈希槽(slot),用于管理数据和节点之间的关系,现在就相当于节点上放的是槽,槽里放的是数据。

哈希槽实质就是一个数组,数组[0,2^14 -1]形成hash slot空间。 2 能干什么解决均匀分配的问题,在数据和节点之间又加入了一层,把这层称为哈希槽(slot),用于管理数据和节点之间的关系,现在就相当于节点上放的是槽,槽里放的是数据。 槽解决的是粒度问题,相当于把粒度变大了,这样便于数据移动。哈希解决的是映射问题,使用key的哈希值来计算所在的槽,便于数据分配。 3 多少个hash槽一个集群只能有16384个槽,编号0-16383(0-2^14-1)。这些槽会分配给集群中的所有主节点,分配策略没有要求。可以指定哪些编号的槽分配给哪个主节点。集群会记录节点和槽的对应关系。解决了节点和槽的关系后,接下来就需要对key求哈希值,然后对16384取余,余数是几key就落入对应的槽里。slot = CRC16(key) % 16384。以槽为单位移动数据,因为槽的数目是固定的,处理起来比较容易,这样数据移动问题就解决了。

槽解决的是粒度问题,相当于把粒度变大了,这样便于数据移动。哈希解决的是映射问题,使用key的哈希值来计算所在的槽,便于数据分配。 3 多少个hash槽一个集群只能有16384个槽,编号0-16383(0-2^14-1)。这些槽会分配给集群中的所有主节点,分配策略没有要求。可以指定哪些编号的槽分配给哪个主节点。集群会记录节点和槽的对应关系。解决了节点和槽的关系后,接下来就需要对key求哈希值,然后对16384取余,余数是几key就落入对应的槽里。slot = CRC16(key) % 16384。以槽为单位移动数据,因为槽的数目是固定的,处理起来比较容易,这样数据移动问题就解决了。- 哈希槽计算

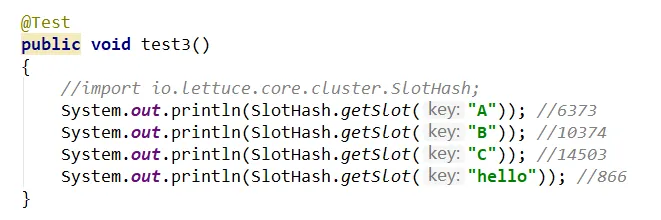

Redis 集群中内置了 16384 个哈希槽,redis 会根据节点数量大致均等的将哈希槽映射到不同的节点。当需要在 Redis 集群中放置一个 key-value时,redis 先对 key 使用 crc16 算法算出一个结果,然后把结果对 16384 求余数,这样每个 key 都会对应一个编号在 0-16383 之间的哈希槽,也就是映射到某个节点上。如下代码,key之A 、B在Node2, key之C落在Node3上

1.2.2、3主3从redis集群扩缩容配置案例架构说明·

1.2.3 安装redis集群·

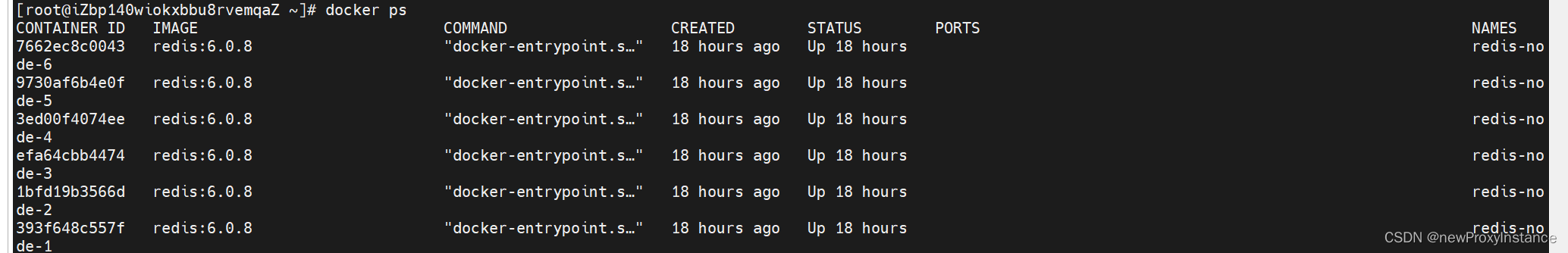

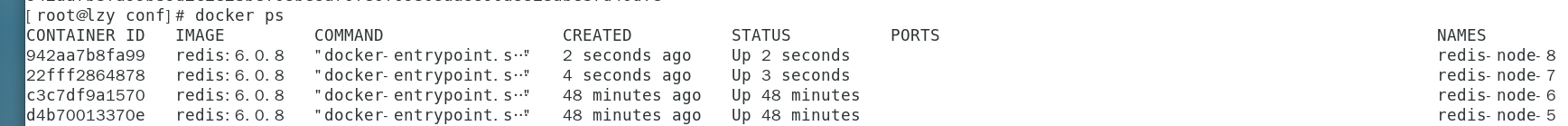

1、 新建6个docker容器redis实例·

1 | docker run -d \ |

命令分步解释 docker run 创建并运行docker容器实例 –name redis-node-6 容器名字 –net host 使用宿主机的IP和端口,默认 –privileged=true 获取宿主机root用户权限 -v /data/redis/share/redis-node-6:/data 容器卷,宿主机地址:docker内部地址 redis:6.0.8 redis镜像和版本号 –cluster-enabled yes 开启redis集群 –appendonly yes 开启持久化 –port 6386 redis端口号

2、配置主从·

1 | redis-cli --cluster create |

–cluster-replicas 1 的 意思是一主一从

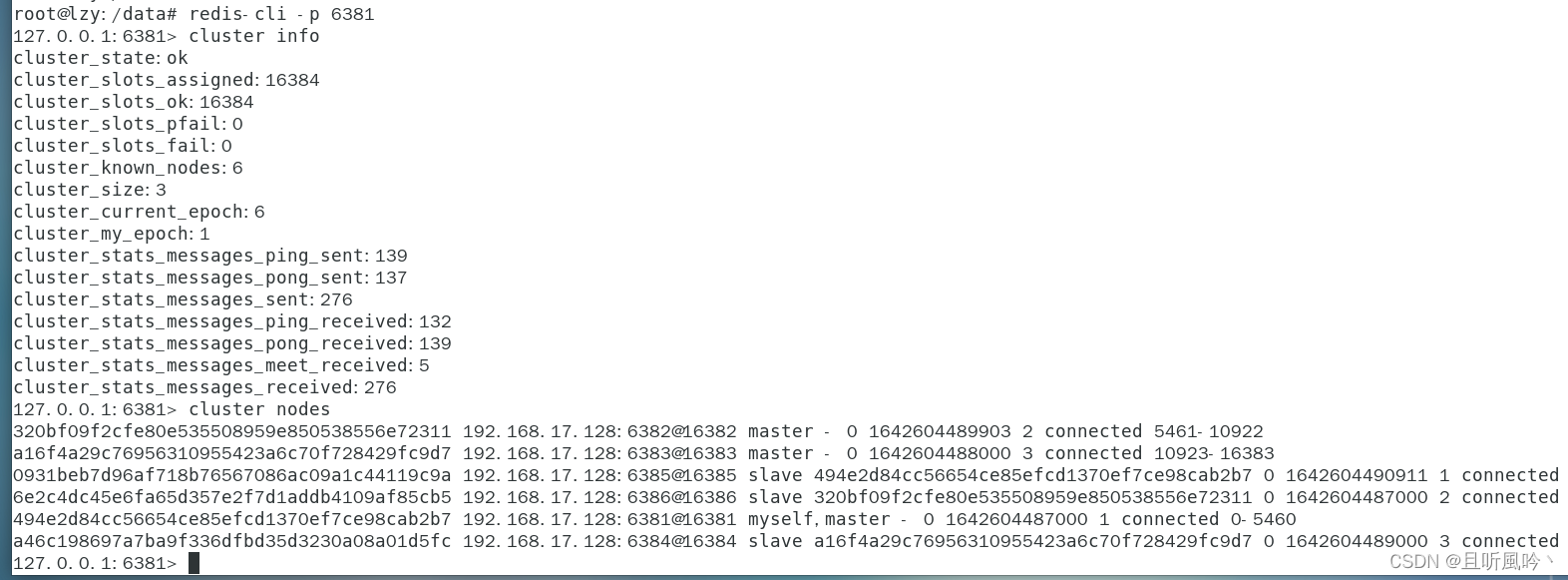

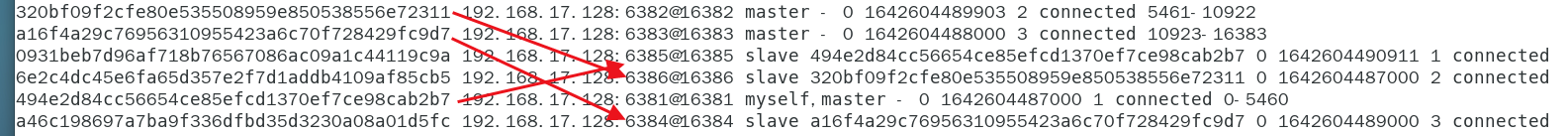

链接进入6381作为切入点,查看集群状态链接进入6381作为切入点,查看节点状态

1 | redis-cli -p 6381 |

挂载关系 1主5从,2主6从,3主4从

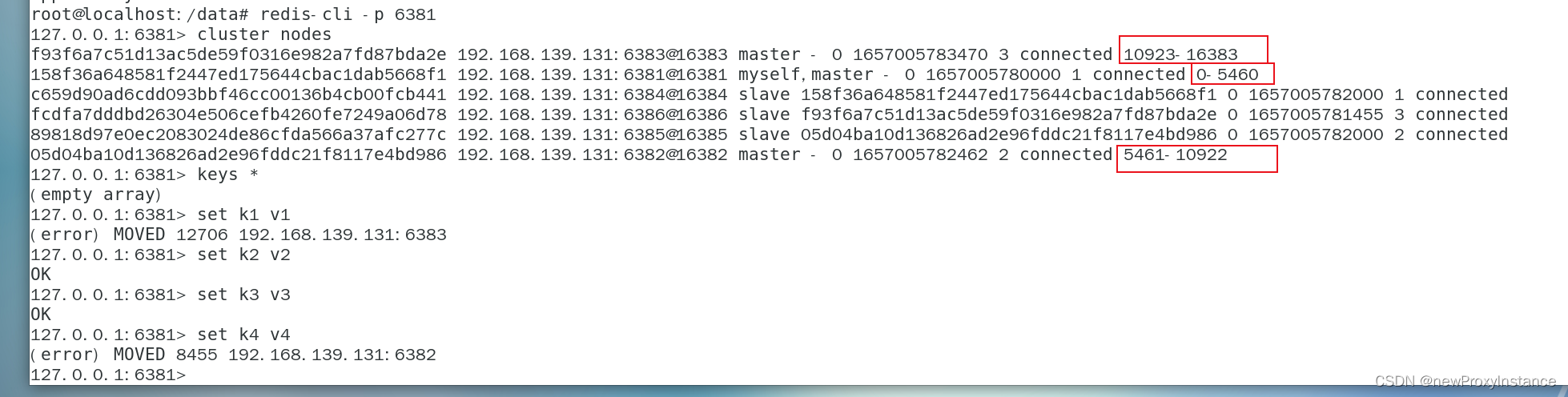

3、读写error说明·

4、集群读写路由增强·

以集群的形式连接

防止路由失效加参数-c并新增两个key

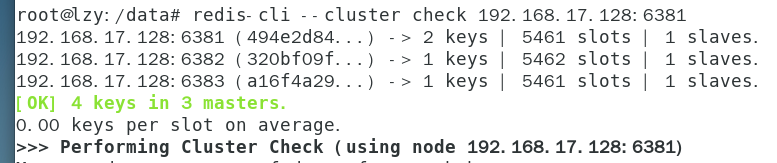

5、查看集群状态·

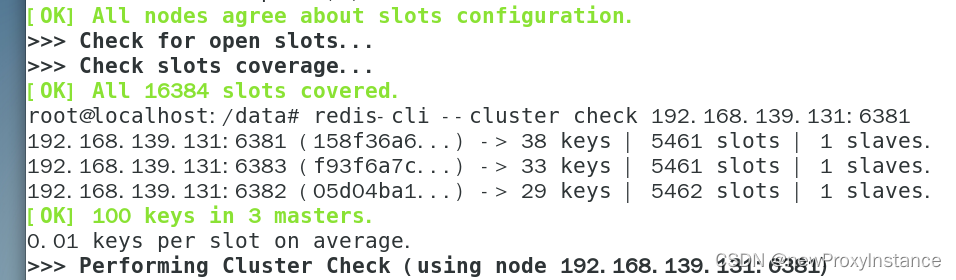

1 | redis-cli --cluster check 192.168.17.128:6381 |

1.2.4、主从切换·

关闭1号节点,观察集群主从状态。

可以发现可以顺利取出之前存的4个key

将node1启动回来,发现主从关系没有重新改变,从节点升为主节点,之前的主节点变为从节点

1.2.5、主从扩容·

操作步骤

- 启动redis容器6387 6388

- 将6387节点加入集群

- 查看集群状态

- 重新分配槽号

- 第二次查看集群状态

- 为6387分配6388从节点

- 第三次查看集群状态

1、启动容器6387 6388·

1 | docker run -d \ |

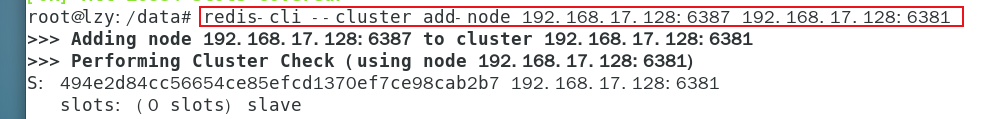

2、将6387master节点添加进集群·

1 | redis-cli --cluster add-node 192.168.17.128:6387 192.168.17.128:6381 |

3、第一次查看集群状态·

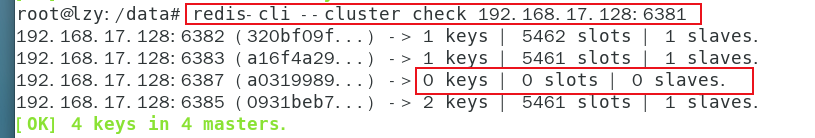

1 | redis-cli --cluster check 192.168.17.128:6381 |

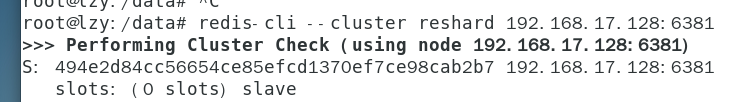

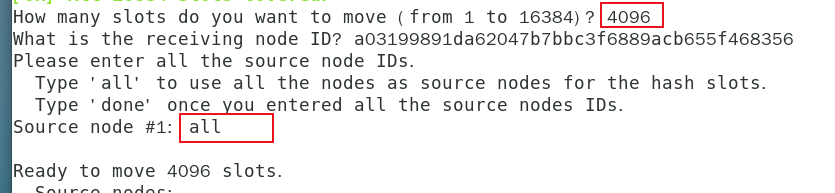

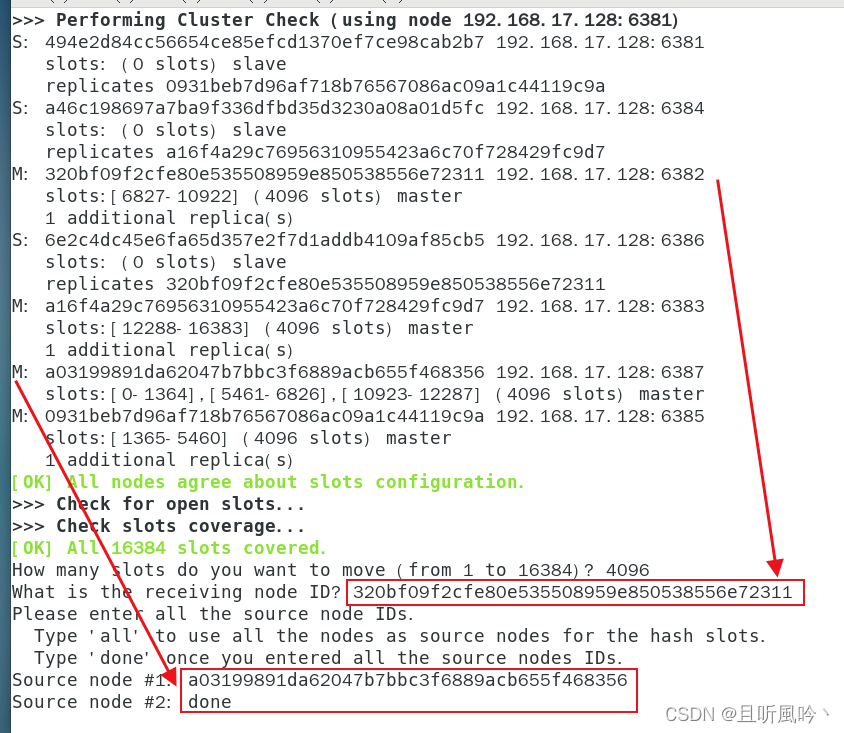

4、重新分派槽号·

1 | redis-cli --cluster reshard 192.168.17.128:6381 |

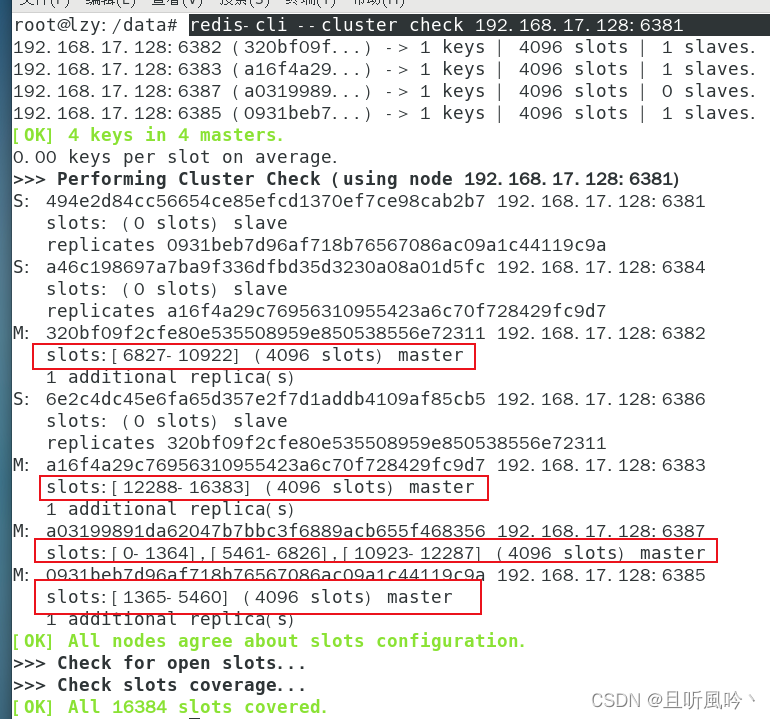

5、第二次查看集群状态·

1 | redis-cli --cluster check 192.168.17.128:6381 |

6、为主节点6387分配从节点6388·

1 | redis-cli --cluster add-node 192.168.17.128:6388 192.168.17.128:6387 --cluster-slave --cluster-master-id a03199891da62047b7bbc3f6889acb655f468356 |

7、第三次检查集群状态·

1 | redis-cli --cluster check 192.168.17.128:6381 |

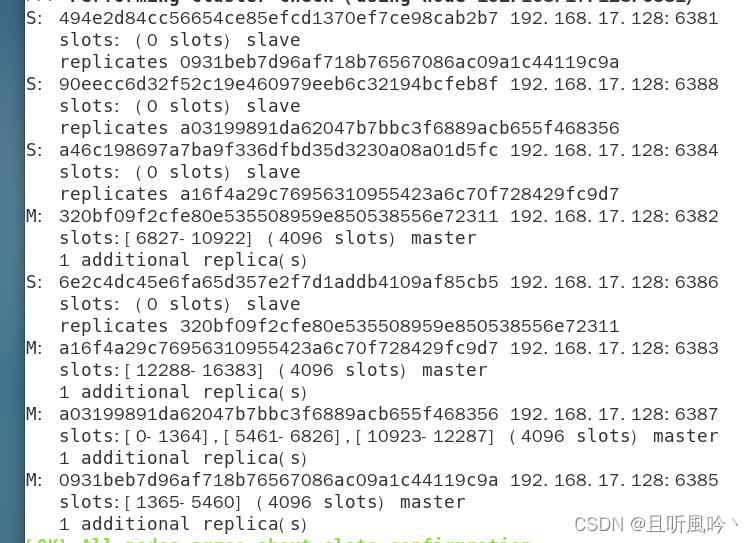

1.2.6、主从缩容·

操作步骤

- 查看集群情况获得6388节点id

- 删除6388节点

- 将6387槽号重新分配

- 检查集群情况

- 将6387删除

- 检查集群情况

1、获取节点id·

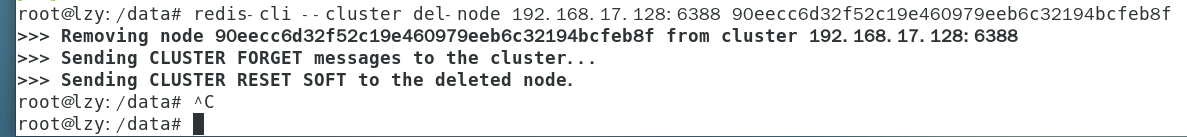

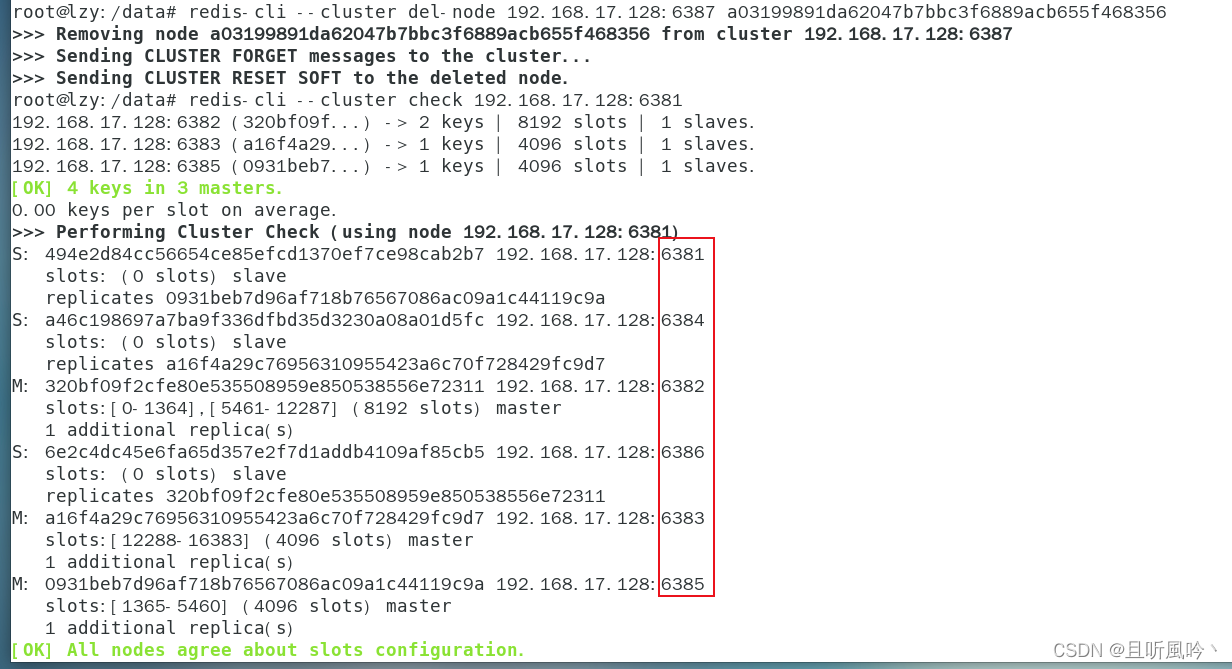

2、集群删除节点6388·

1 | redis-cli --cluster del-node 192.168.17.128:6388 90eecc6d32f52c19e460979eeb6c32194bcfeb8f |

3、重新分配slot·

本例将6387的slot全部分给6382节点

1 | redis-cli --cluster reshard 192.168.17.128:6381 |

4、查看集群状态·

发现6387节点已经没有slot

5、删除6387节点·

1 | redis-cli --cluster del-node 192.168.17.128:6387 a03199891da62047b7bbc3f6889acb655f468356 |

1.2.7、Spring Boot 连接集群·

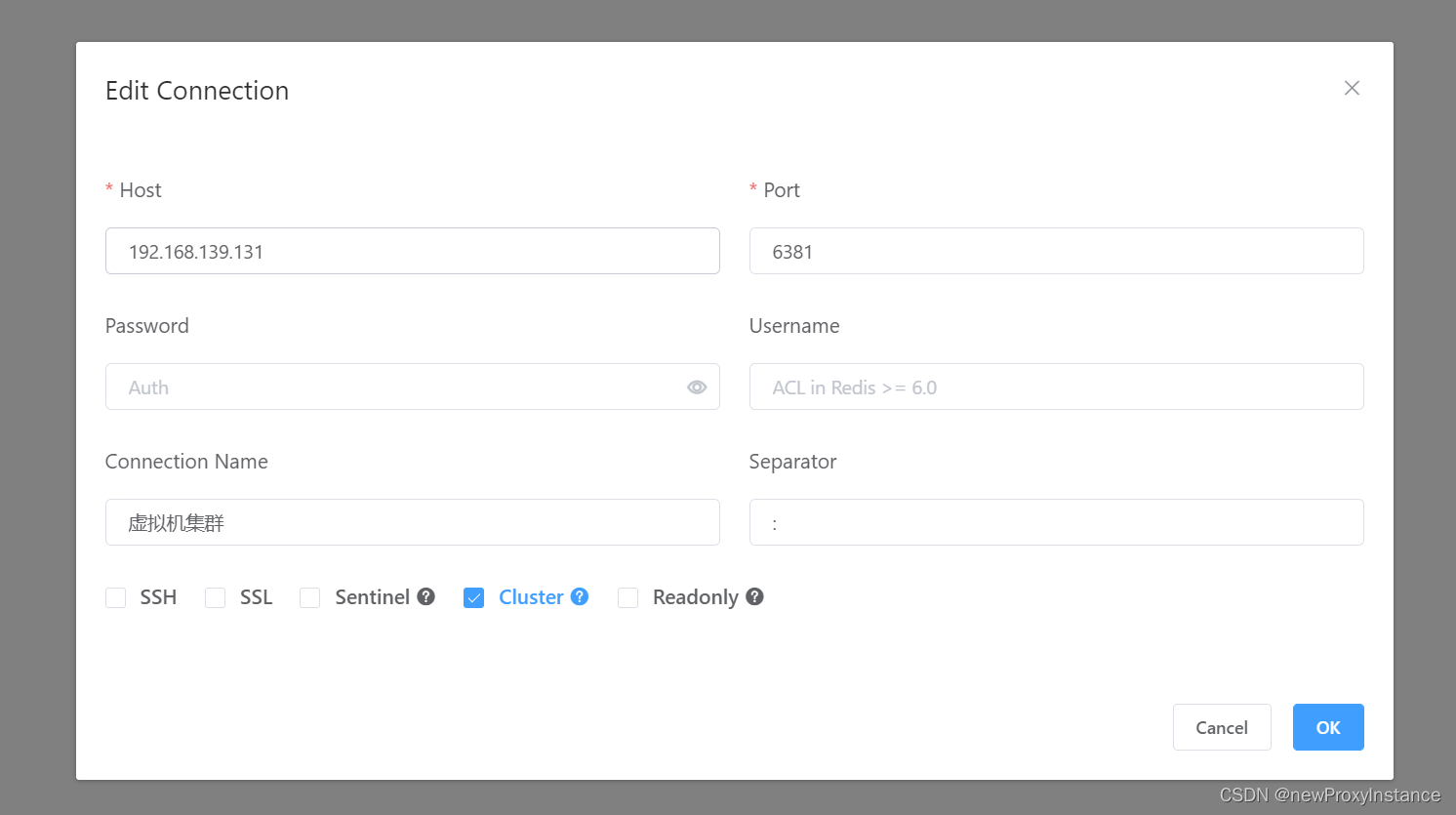

这里以 Another Redis Desktop Manager为例来演示连接集群,配置如下图所示,ip要改成自己的集群。

1、注意事项和搭建·

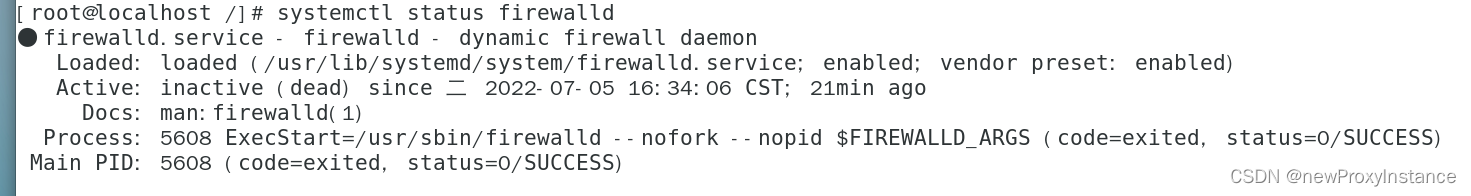

注意这三个命令,如果工具连不上很有可能是这个原因。

经过测试,如果开启防火墙,工具会立马断开连接。

1 | systemctl start firewalld |

yml 配置文件,配置相关集群节点。

1 | spring: |

编写一个简单的Controller来测试存值。

1 |

|

2、查看工具中key的状态·

过期前

过期后

3、查看集群状态·

1 | redis-cli --cluster check 192.168.139.131:6381 |

key 生效后查询状态

key 过期后再次查询状态

第 十 章 DockerFile解析·

是什么·

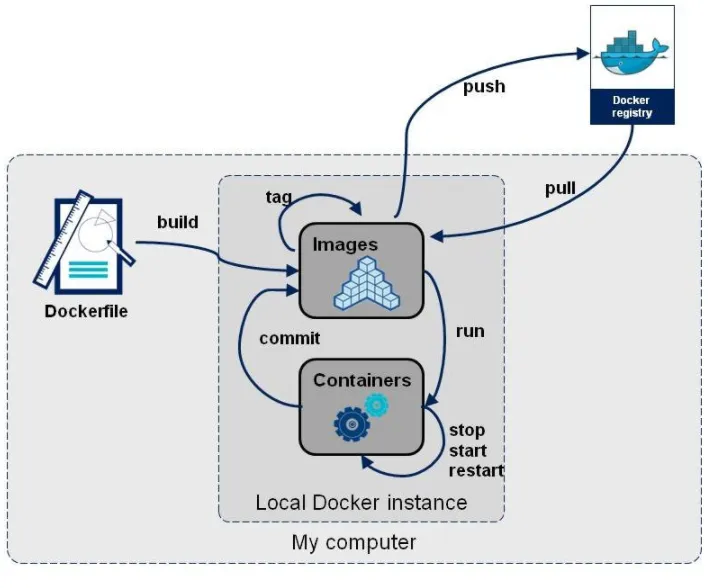

Dockerfile是用来构建Docker镜像的文本文件,是由一条条构建镜像所需的指令和参数构成的脚本。

概述·

官网·

https://docs.docker.com/engine/reference/builder/

构建三步骤·

- 编写Dockerfile文件

- docker build 命令构建镜像

- docker run 镜像 运行容器实例

DockerFile构建过程解析·

Dockerfile内容基础知识·

- 每条保留字指令都必须为大写字母且后面要跟随至少一个参数

- 指令按照从上到下,顺序执行

- #表示注释

- 每条指令都会创建一个新的镜像层并对镜像进行提交

Docker执行Dockerfile的大致流程·

- docker从基础镜像运行一个容器

- 执行一条指令并对容器作出修改

- 执行类似docker commit的操作提交一个新的镜像层

- docker再基于刚提交的镜像运行一个新容器

- 执行dockerfile中的下一条指令直到所有指令都执行完成

小总结·

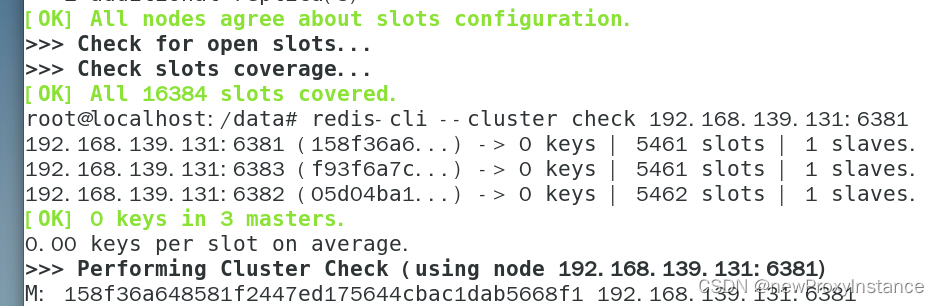

从应用软件的角度来看,Dockerfile、Docker镜像与Docker容器分别代表软件的三个不同阶段, ● Dockerfile是软件的原材料 ● Docker镜像是软件的交付品 ● Docker容器则可以认为是软件镜像的运行态,也即依照镜像运行的容器实例 Dockerfile面向开发,Docker镜像成为交付标准,Docker容器则涉及部署与运维,三者缺一不可,合力充当Docker体系的基石。

- Dockerfile,需要定义一个Dockerfile,Dockerfile定义了进程需要的一切东西。Dockerfile涉及的内容包括执行代码或者是文件、环境变量、依赖包、运行时环境、动态链接库、操作系统的发行版、服务进程和内核进程(当应用进程需要和系统服务和内核进程打交道,这时需要考虑如何设计namespace的权限控制)等等;

- Docker镜像,在用Dockerfile定义一个文件之后,docker build时会产生一个Docker镜像,当运行 Docker镜像时会真正开始提供服务;

- Docker容器,容器是直接提供服务的。

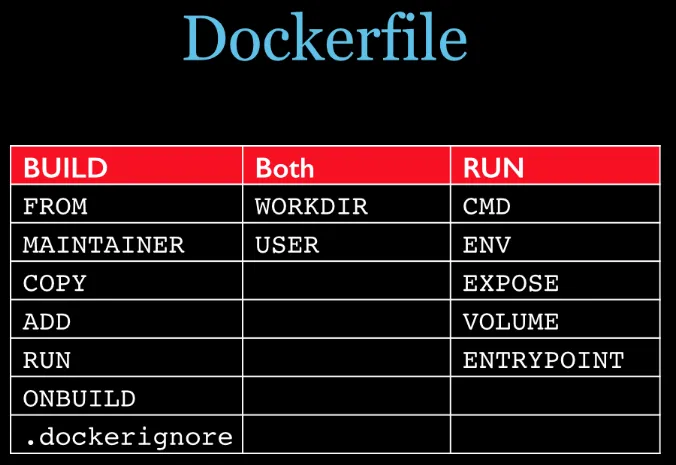

DockerFile常用保留字指令·

参考tomcat8的dockerfile入门·

https://github.com/docker-library/tomcat

FROM·

基础镜像,当前新镜像是基于哪个镜像的,指定一个已经存在的镜像作为模板,第一条必须是from

MAINTAINER·

镜像维护者的姓名和邮箱地址

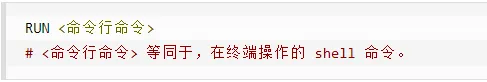

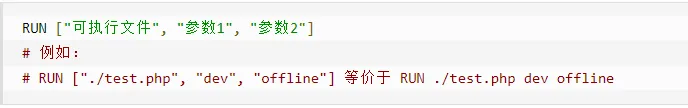

RUN·

容器构建时需要运行的命令两种格式

shell格式

exec格式

RUN是在 docker build时运行

EXPOSE·

当前容器对外暴露出的端口

WORKDIR·

指定在创建容器后,终端默认登陆的进来工作目录,一个落脚点

USER·

指定该镜像以什么样的用户去执行,如果都不指定,默认是root

ENV·

用来在构建镜像过程中设置环境变量

这个环境变量可以在后续的任何RUN指令中使用,这就如同在命令前面指定了环境变量前缀一样;也可以在其它指令中直接使用这些环境变量。比如:

ADD·

将宿主机目录下的文件拷贝进镜像且会自动处理URL和解压tar压缩包

COPY·

类似ADD,拷贝文件和目录到镜像中。将从构建上下文目录中 <源路径> 的文件/目录复制到新的一层的镜像内的 <目标路径> 位置

2

COPY ["src", "dest"]<src源路径>:源文件或者源目录 <dest目标路径>:容器内的指定路径,该路径不用事先建好,路径不存在的话,会自动创建。

VOLUME·

容器数据卷,用于数据保存和持久化工作

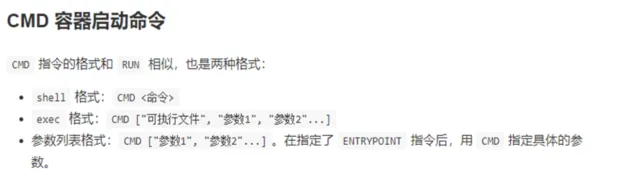

CMD·

指定容器启动后的要干的事情

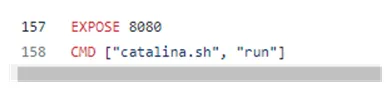

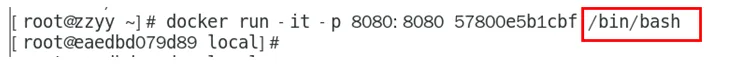

注意: Dockerfile 中可以有多个 CMD 指令,但只有最后一个生效,CMD 会被 docker run 之后的参数替换。参考官网Tomcat的dockerfile演示讲解:

官网最后一行命令

我们演示自己的覆盖操作

它和前面RUN命令的区别 ● CMD是在docker run 时运行。 ● RUN是在 docker build 时运行。

ENTRYPOINT·

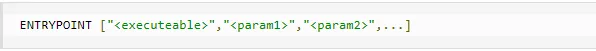

也是用来指定一个容器启动时要运行的命令类似于 CMD 指令,但是ENTRYPOINT不会被docker run后面的命令覆盖, 而且这些命令行参数会被当作参数送给 ENTRYPOINT 指令指定的程序。命令格式和案例说明

命令格式:

ENTRYPOINT可以和CMD一起用,一般是变参才会使用 CMD ,这里的 CMD 等于是在给 ENTRYPOINT 传参。当指定了ENTRYPOINT后,CMD的含义就发生了变化,不再是直接运行其命令而是将CMD的内容作为参数传递给ENTRYPOINT指令,他两个组合会变成

案例如下:假设已通过 Dockerfile 构建了 nginx:test 镜像:

优点:在执行docker run的时候可以指定 ENTRYPOINT 运行所需的参数。注意:如果 Dockerfile 中如果存在多个 ENTRYPOINT 指令,仅最后一个生效。

小总结·

案例·

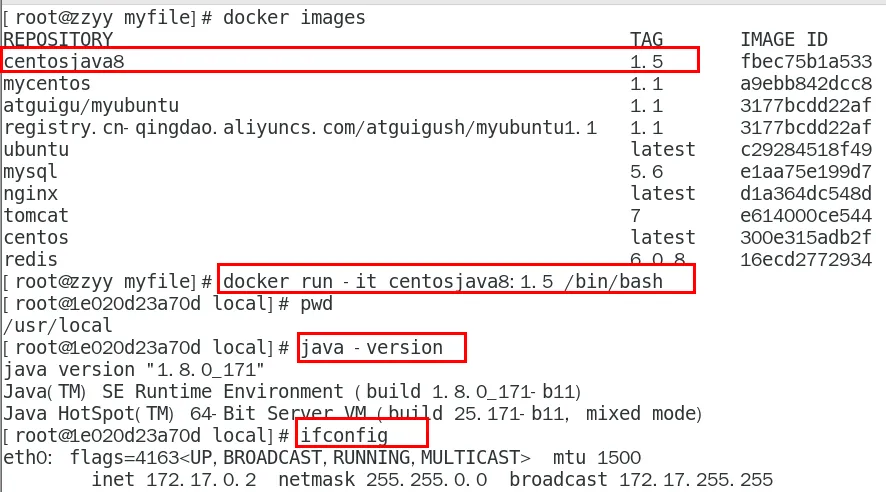

自定义镜像mycentosjava8·

要求·

Centos7镜像具备vim+ifconfig+jdk8

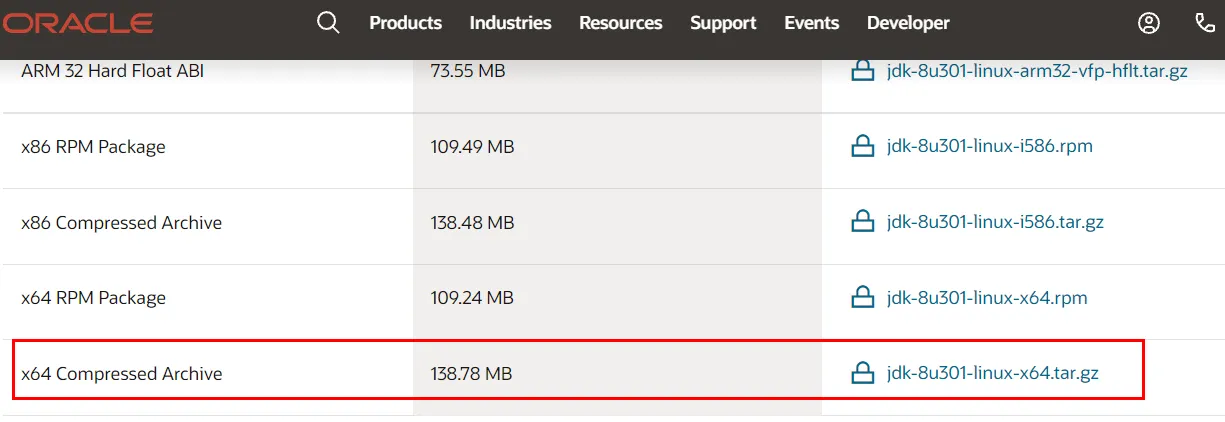

JDK的下载镜像地址:https://www.oracle.com/java/technologies/downloads/#java8

https://mirrors.yangxingzhen.com/jdk/

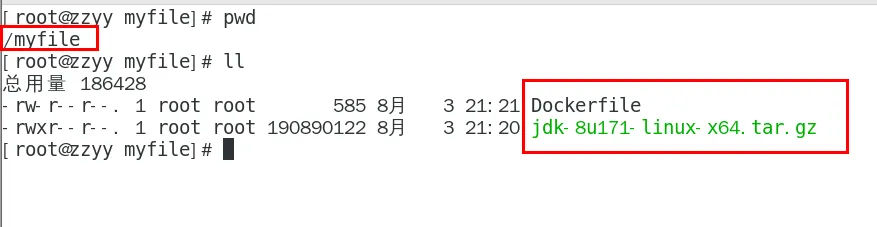

编写·

准备编写Dockerfile文件

1 | FROM centos |

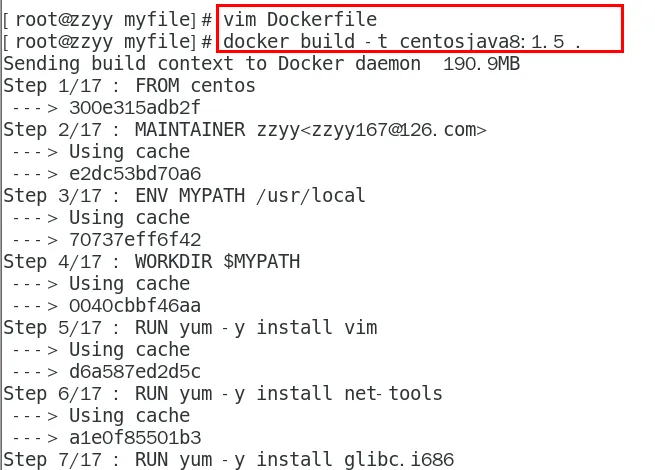

构建·

docker build -t 新镜像名字:TAG .

1 | docker build -t centosjava8:1.5 . |

注意,上面TAG后面有个空格,有个点

运行·

docker run -it 新镜像名字:TAG

1 | docker run -it centosjava8:1.5 /bin/bash |

再体会下UnionFS(联合文件系统)·

UnionFS(联合文件系统):Union文件系统(UnionFS)是一种分层、轻量级并且高性能的文件系统,它支持对文件系统的修改作为一次提交来一层层的叠加,同时可以将不同目录挂载到同一个虚拟文件系统下(unite several directories into a single virtual filesystem)。Union 文件系统是 Docker 镜像的基础。镜像可以通过分层来进行继承,基于基础镜像(没有父镜像),可以制作各种具体的应用镜像。

特性:一次同时加载多个文件系统,但从外面看起来,只能看到一个文件系统,联合加载会把各层文件系统叠加起来,这样最终的文件系统会包含所有底层的文件和目录

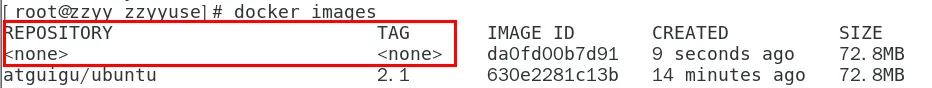

虚悬镜像·

是什么·

仓库名、标签都是

vim Dockerfile内容

1

2from ubuntu

CMD echo 'action is success'docker build .

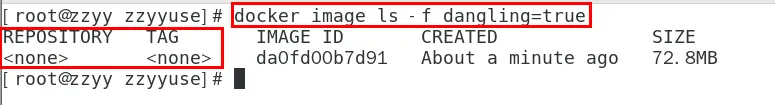

查看·

1 | docker image ls -f dangling=true |

命令结果

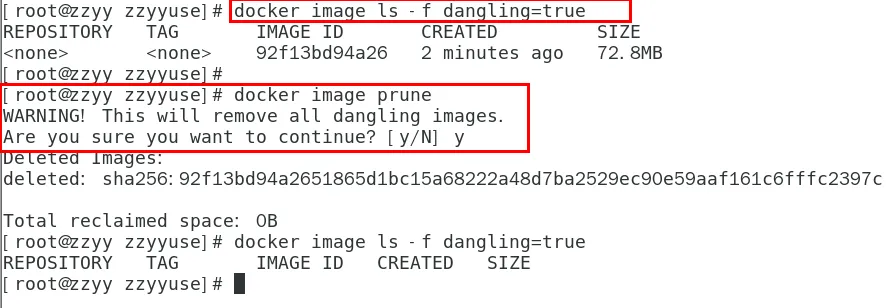

删除·

docker image prune

虚悬镜像已经失去存在价值,可以删除

家庭作业-自定义镜像myubuntu·

编写·

准备编写DockerFile文件

1 | FROM ubuntu |

构建·

docker build -t 新镜像名字:TAG .

运行·

docker run -it 新镜像名字:TAG

小总结·

第 十一章 Docker微服务实战·

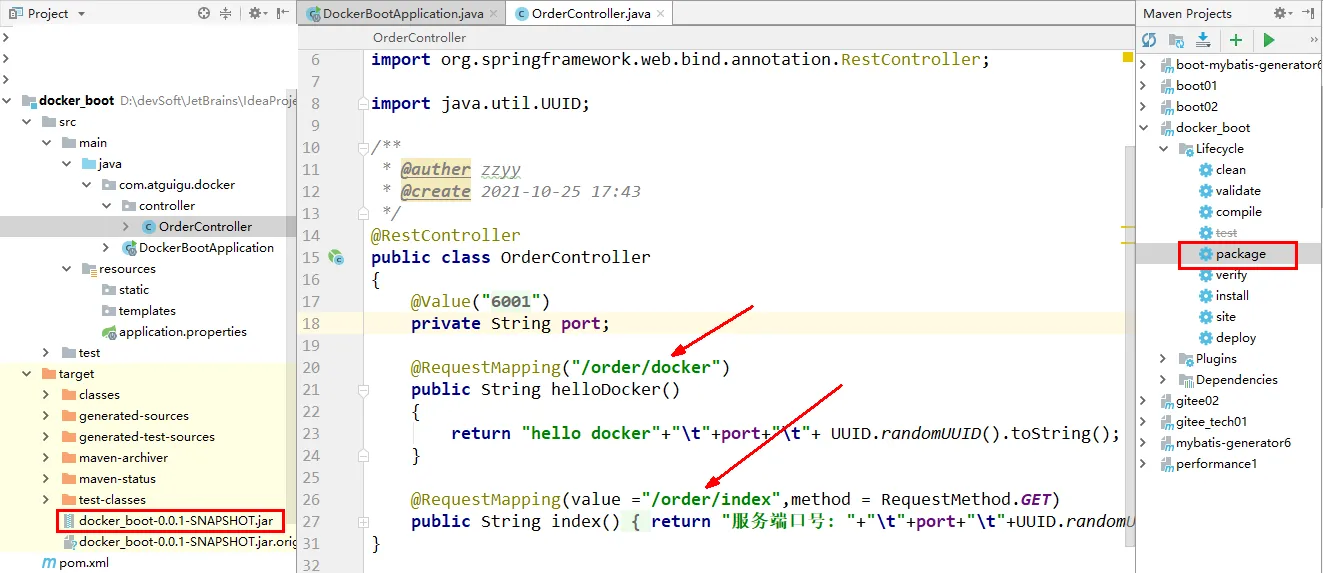

通过IDEA新建一个普通微服务模块·

建Module·

docker_boot

改POM·

1 |

|

写YML·

server.port=6001

主启动·

1 | package com.atguigu.docker; |

业务类·

1 | package com.atguigu.docker.controller; |

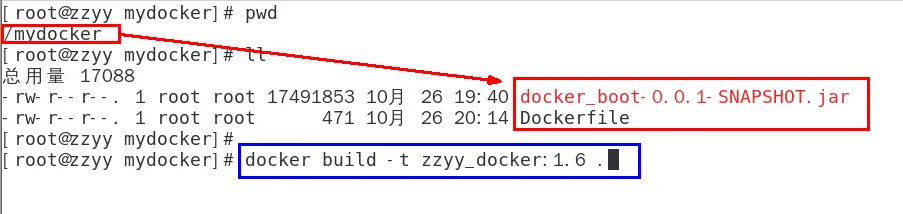

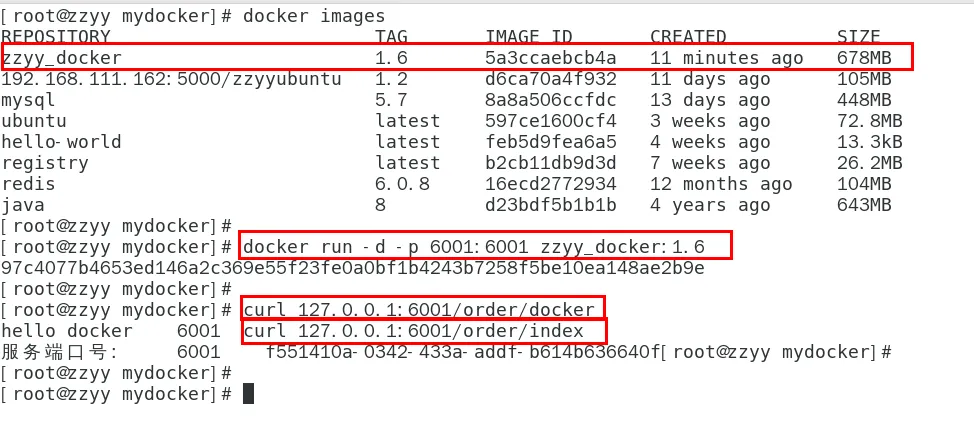

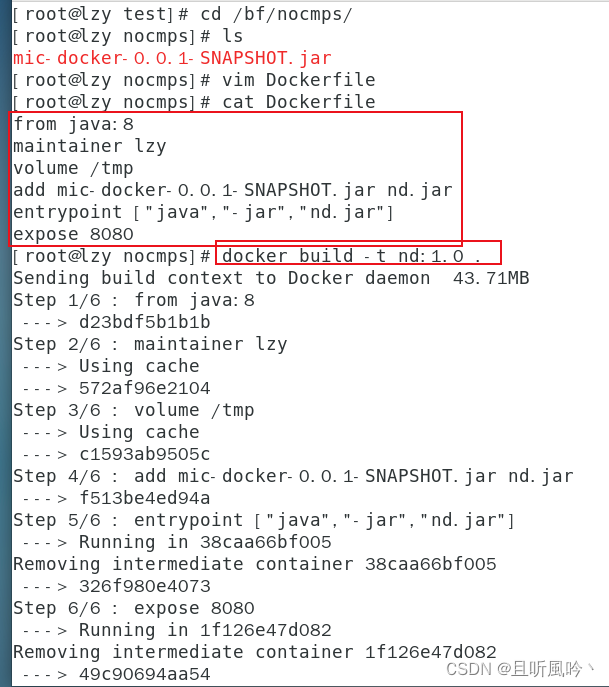

通过dockerfile发布微服务部署到docker容器·

IDEA工具里面搞定微服务jar包·

docker_boot-0.0.1-SNAPSHOT.jar

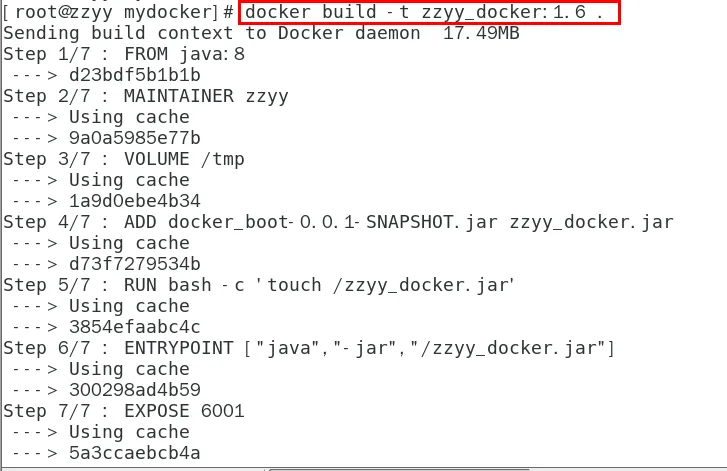

编写Dockerfile·

1 | # 基础镜像使用java |

将微服务jar包和Dockerfile文件上传到同一个目录下/mydocker

docker build -t zzyy_docker:1.6 .

构建镜像·

docker build -t zzyy_docker:1.6 .

打包成镜像文件

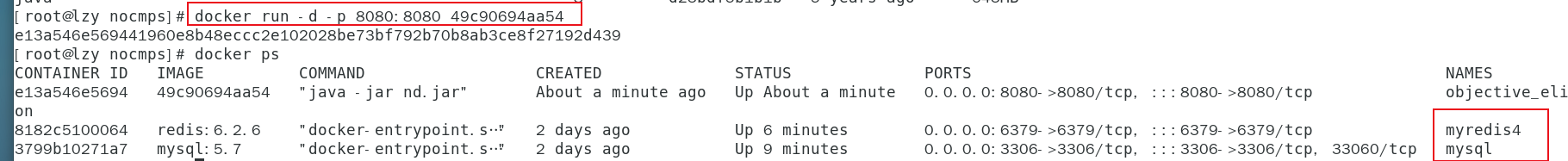

运行容器·

docker run -d -p 6001:6001 zzyy_docker:1.6

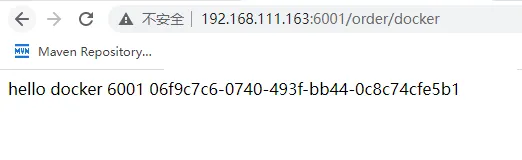

访问测试·

·

是什么·

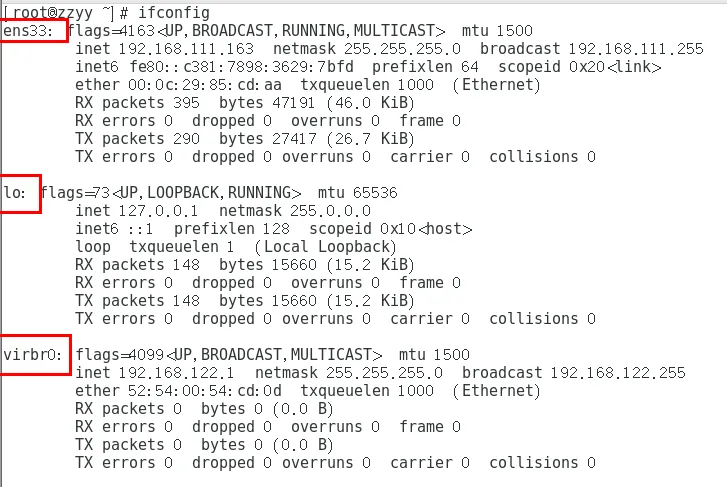

docker不启动,默认网络情况·

ens33

lo

virbr0

在CentOS7的安装过程中如果有选择相关虚拟化的的服务安装系统后,启动网卡时会发现有一个以网桥连接的私网地址的virbr0网卡(virbr0网卡:它还有一个固定的默认IP地址192.168.122.1),是做虚拟机网桥的使用的,其作用是为连接其上的虚机网卡提供 NAT访问外网的功能。

我们之前学习Linux安装,勾选安装系统的时候附带了libvirt服务才会生成的一个东西,如果不需要可以直接将libvirtd服务卸载, yum remove libvirt-libs.x86_64

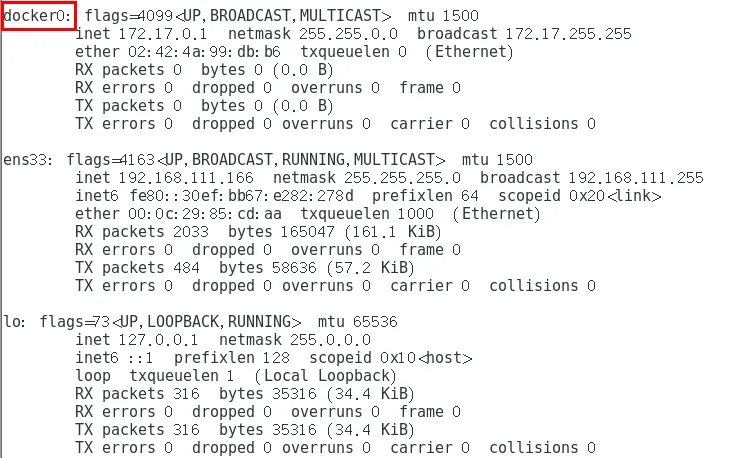

docker启动后,网络情况·

会产生一个名为docker0的虚拟网桥

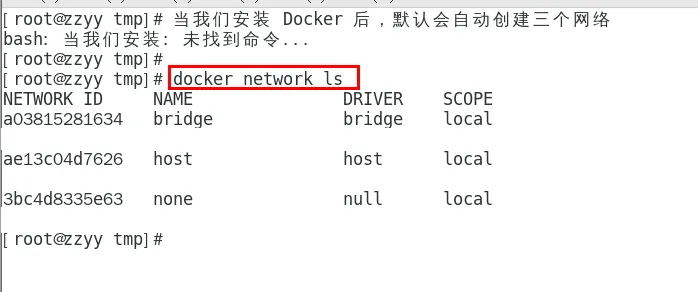

查看docker网络模式命令,默认创建3大网络模式。

常用基本命令·

All命令·

查看网络·

docker network ls

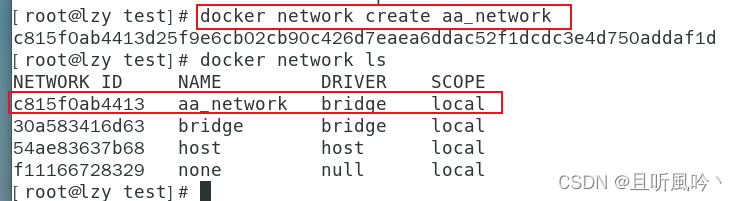

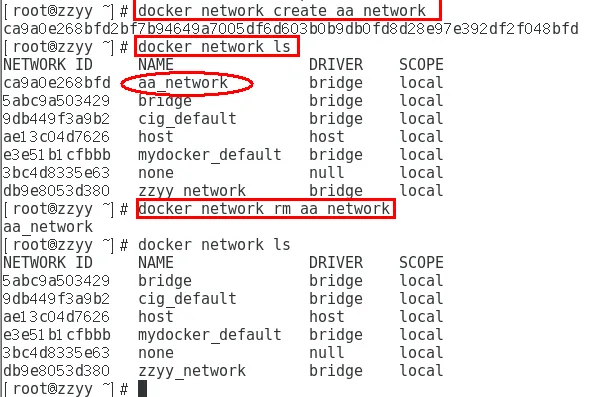

创建网络·

docker network create

查看网络源数据·

docker network inspect XXX网络名字

删除网络·

docker network rm XXX网络名字

案例·

能干嘛·

容器间的互联和通信以及端口映射容器IP变动时候可以通过服务名直接网络通信而不受到影响

网络模式·

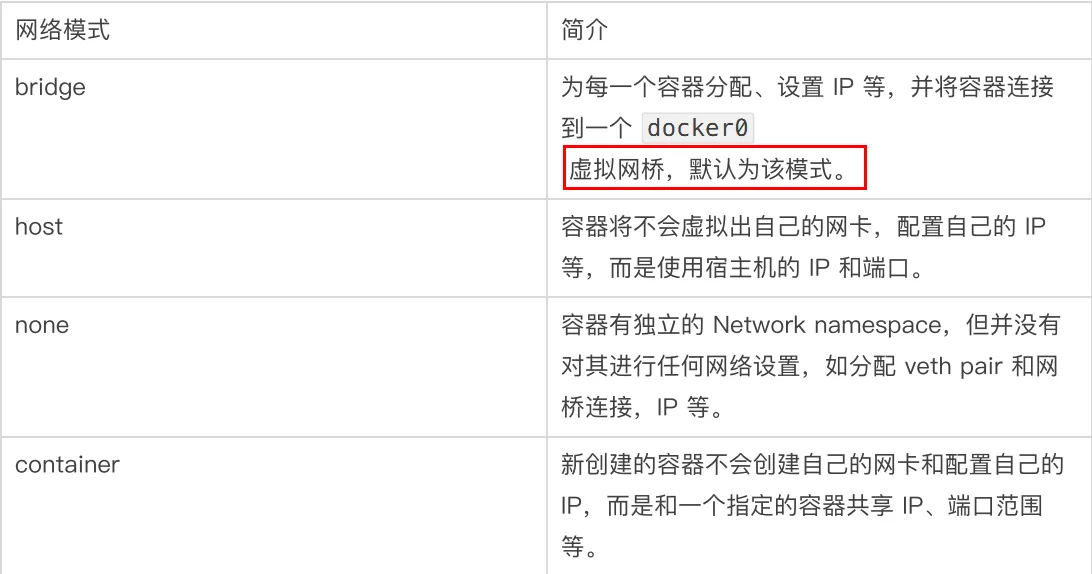

总体介绍·

bridge模式:使用–network bridge指定,默认使用docker0 host模式:使用–network host指定 none模式:使用–network none指定 container模式:使用–network container:NAME或者容器ID指定

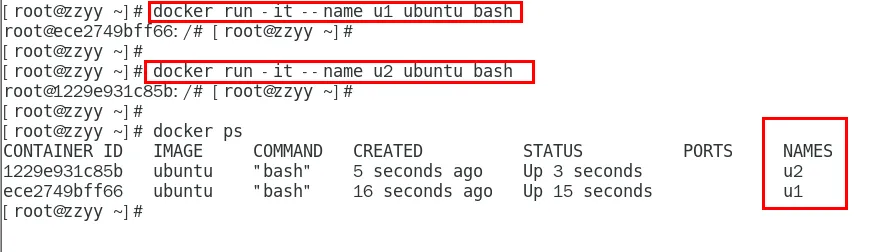

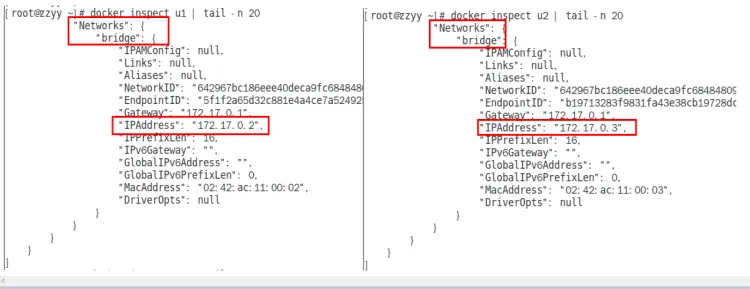

容器实例内默认网络IP生产规则·

先启动两个ubuntu容器实例

docker inspect 容器ID or 容器名字

关闭u2实例,新建u3,查看ip变化

结论

docker容器内部的ip是有可能会发生改变的

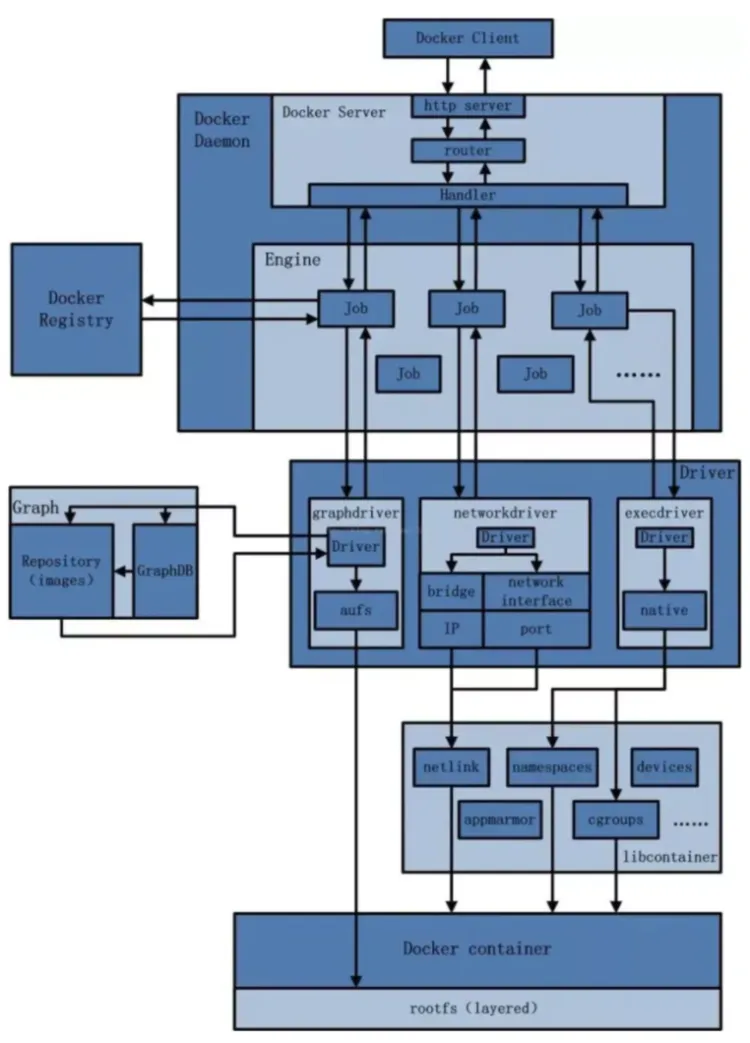

Docker平台架构图解·

整体说明·

从其架构和运行流程来看,Docker 是一个 C/S 模式的架构,后端是一个松耦合架构,众多模块各司其职。 Docker 运行的基本流程为: 1 用户是使用 Docker Client 与 Docker Daemon 建立通信,并发送请求给后者。 2 Docker Daemon 作为 Docker 架构中的主体部分,首先提供 Docker Server 的功能使其可以接受 Docker Client 的请求。 3 Docker Engine 执行 Docker 内部的一系列工作,每一项工作都是以一个 Job 的形式的存在。 4 Job 的运行过程中,当需要容器镜像时,则从 Docker Registry 中下载镜像,并通过镜像管理驱动 Graph driver将下载镜像以Graph的形式存储。 5 当需要为 Docker 创建网络环境时,通过网络管理驱动 Network driver 创建并配置 Docker 容器网络环境。 6 当需要限制 Docker 容器运行资源或执行用户指令等操作时,则通过 Execdriver 来完成。 7 Libcontainer是一项独立的容器管理包,Network driver以及Exec driver都是通过Libcontainer来实现具体对容器进行的操作。

整体架构·

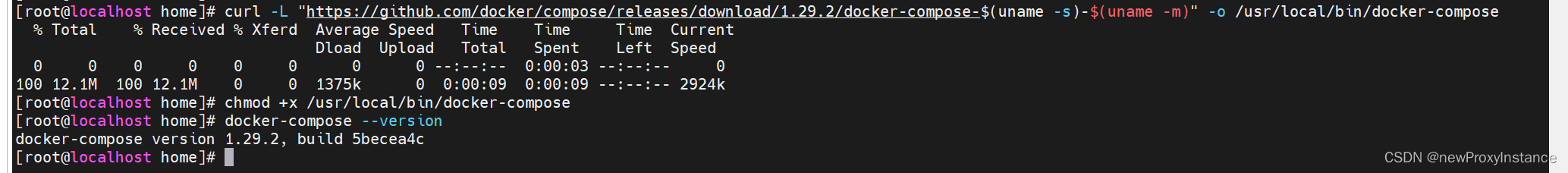

第 十三章 Docker-compose容器编排·

是什么·

Docker-Compose是Docker官方的开源项目, 负责实现对Docker容器集群的快速编排。

下载·

请求git地址下载docker-compose

1 | curl -L "https://github.com/docker/compose/releases/download/1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose |

授权

1 | chmod +x /usr/local/bin/docker-compose |

查看版本

1 | docker-compose --version |

重新制作微服务jar包·

service部分代码如下

1 |

|

配置文件注意要把mysql和redis的路径更换为虚拟机ip

1 | mybatis-plus: |

不用compose编排服务·

操作步骤:

- 编写微服务程序,本地测试并打包后移植虚拟机上

- 编写Dockerfile将jar包变为镜像

- 启动mysql redis jar包三个容器

- 测试插入用户

- 测试获取用户信息

移植虚拟机·

注意jar包大小要和容器外保持一致。

编写Dockerfile将jar包变为镜像·

启动三个容器·

后台启动 redis、mysql、jar 三个容器,查看是否启动成功

测试容器8080能否访问

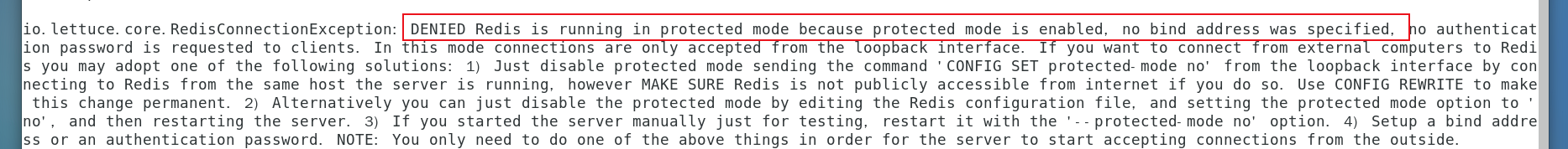

插入用户报错,查看容器日志 docker logs + 容器id。

将redis中protected_mode改为no后重启实例

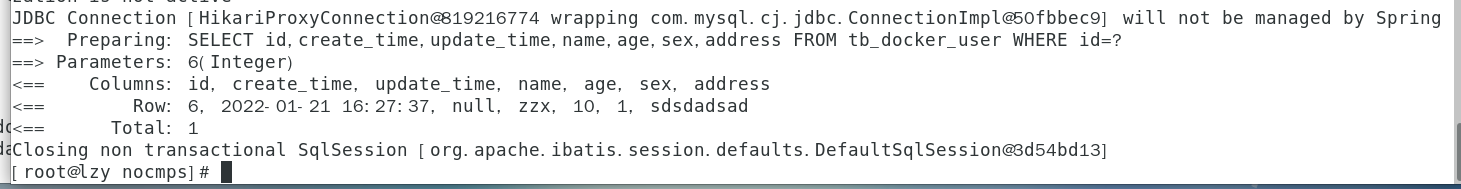

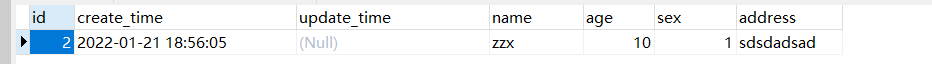

mysql成功插入数据

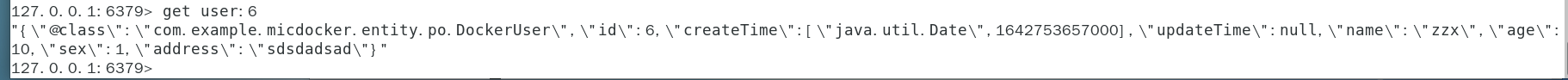

测试 redis 成功获取

数据库记录

测试获取用户接口

根据日志,没有select记录,成功在redis中获取用户信息。

总结 当微服务变多,手动启动容器的难度就会加大,同时也会增加出错概率,这个时候使用compose进行一文件多容器的启动和停止就十分的有必要

compose编排服务·

docker-compose.yml文件内容如图所示

1 | version: "3" |

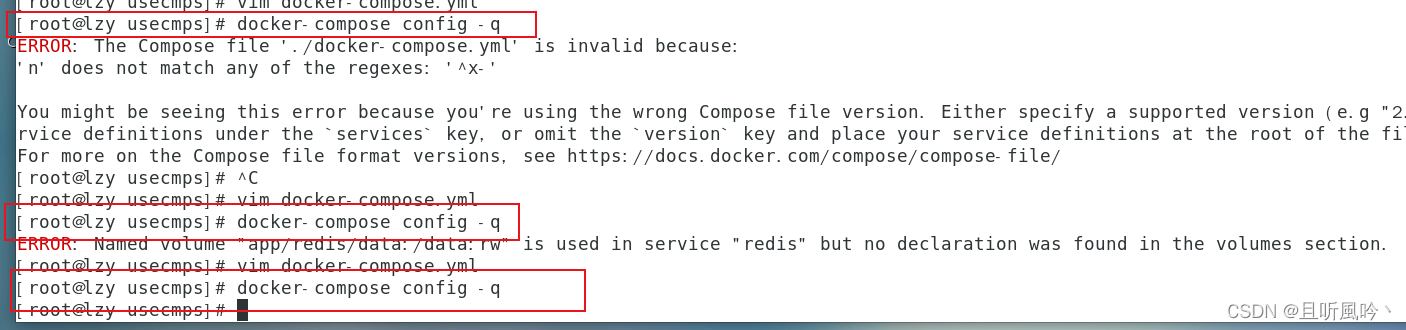

compose文件检查

第一个原因: version拼写错误第二个原因: redis挂载的容器数据卷重复第三个: 无输出代表正常

启动redis和mysql之前,把redis.conf和my.cnf文件复制到相应位置,不然会启动会创建目录

redis.conf和my.cnf目录,虽然不会报错,但是读取不到配置文件。

docker-compose up -d·

启动命令如下

1 | docker-compose up -d |

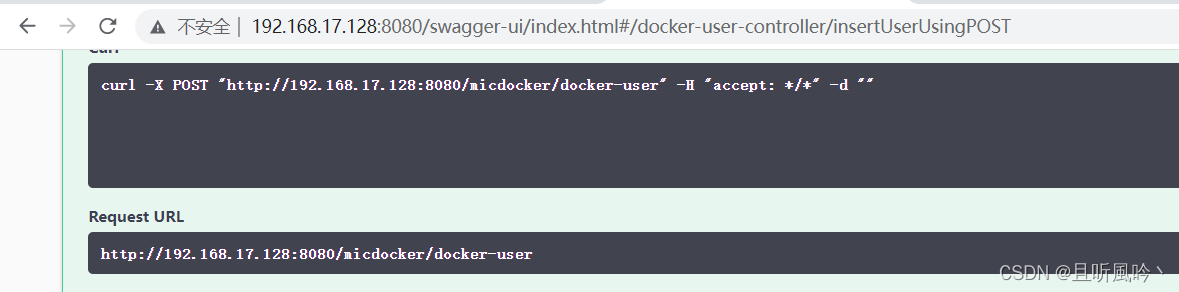

访问swagger测试insert

进入redis容器内容,尝试获取user:2的值

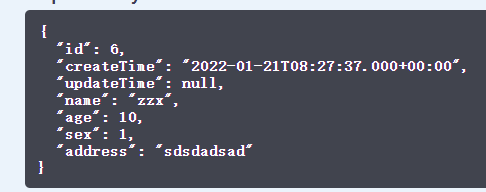

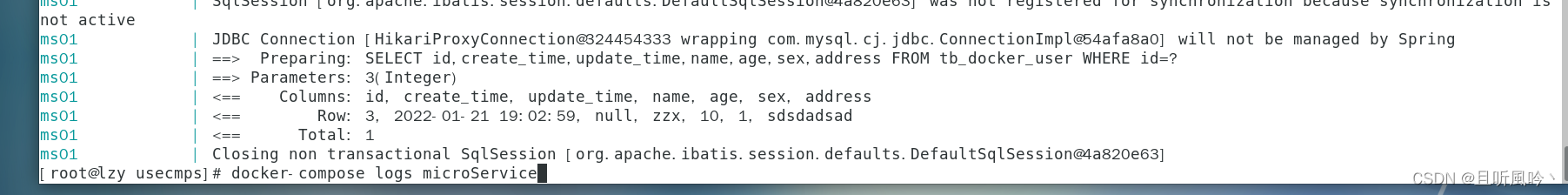

测试查询接口,可以看到成功获取到id=3的用户

通过这个命令可以查看日志

1 | docker-compose logs microService |

通过查看日志得出查询id=3走的redis,测试成功

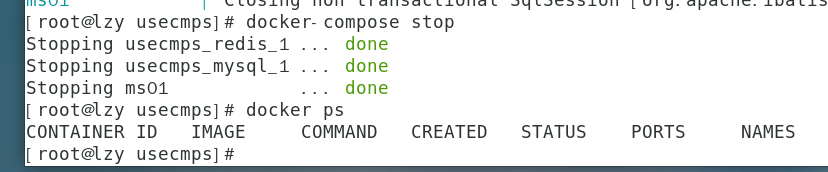

docker-compose stop·

docker-compose start·

docker-compose restart·

docker-compose 常用命令·

1 | docker-compose -h #查看帮助 |

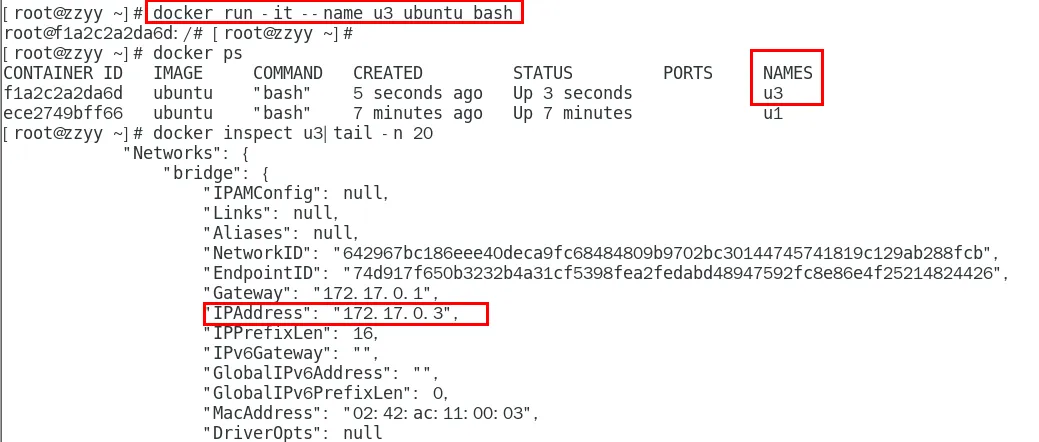

第 十四章 Docker轻量级可视化工具Portainer·

是什么·

Portainer 是一款轻量级的应用,它提供了图形化界面,用于方便地管理Docker环境,包括单机环境和集群环境。

安装·

官网·

https://www.portainer.io/ https://docs.portainer.io/v/ce-2.9/start/install/server/docker/linux

步骤·

- docker命令安装

1 | docker run -d -p 8000:8000 -p 9000:9000 |

- 第一次登录需创建admin,访问地址:xxx.xxx.xxx.xxx:9000

用户名,直接用默认admin 密码记得8位,随便你写

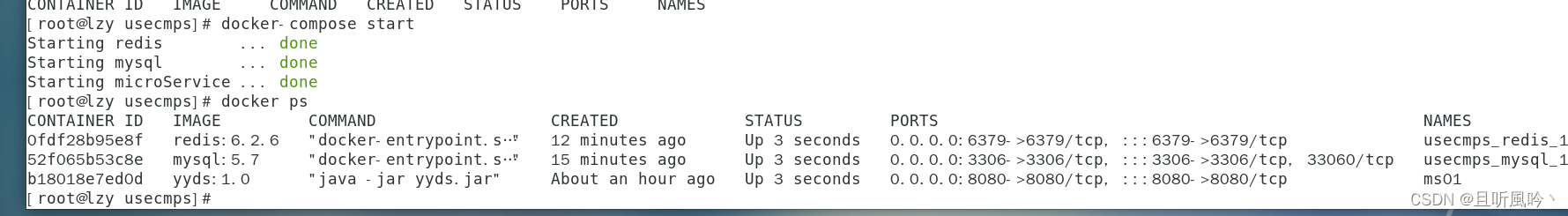

- 设置admin用户和密码后首次登陆

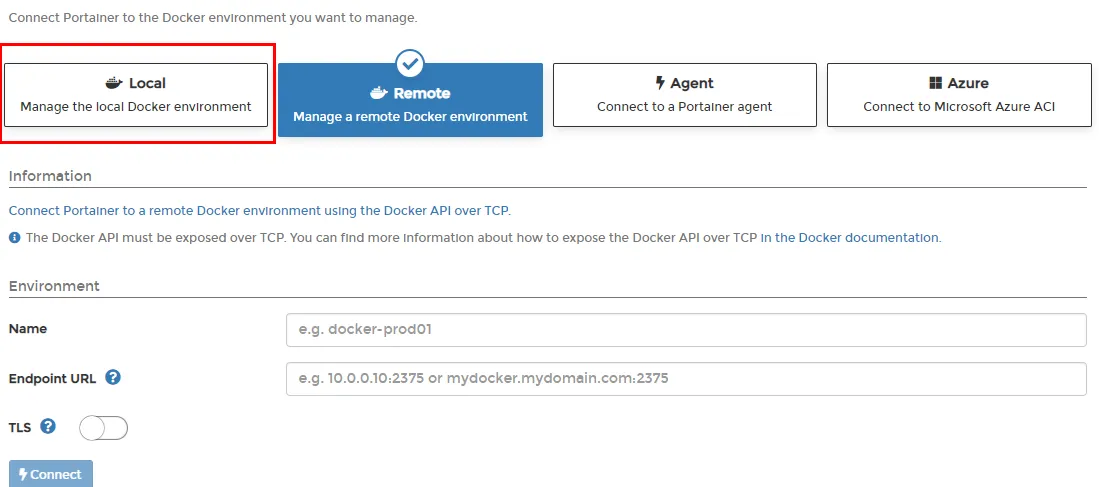

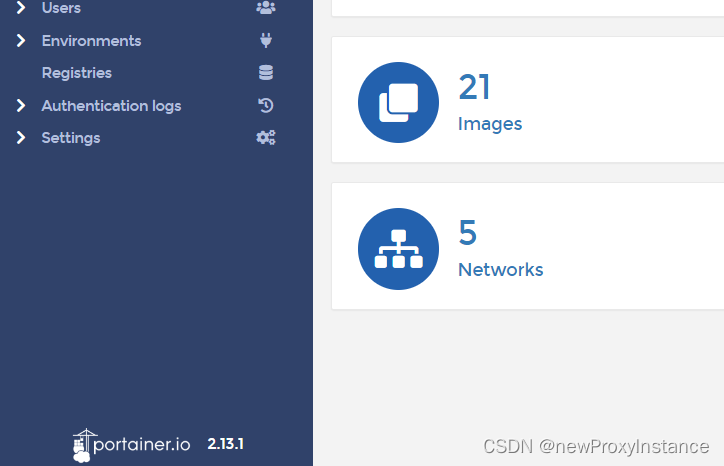

- 选择local选项卡后本地docker详细信息展示

更新版本·

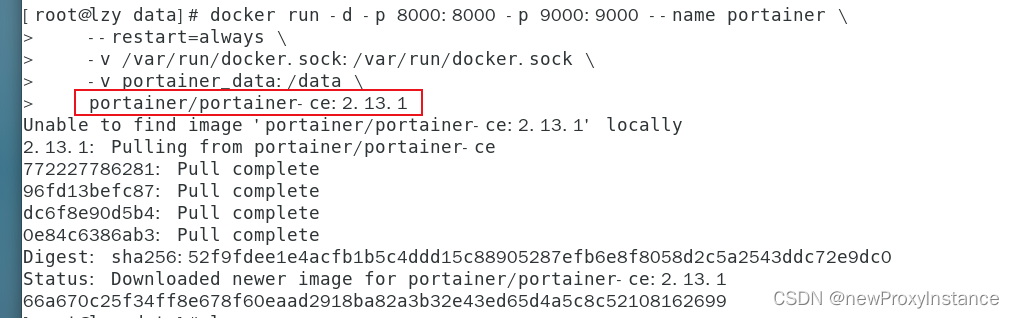

步骤如下,首先停止容器,删除容器,删除镜像,以2.13.1版本为例,运行下面代码启动

1 | docker run -d -p 8000:8000 -p 9000:9000 --name portainer \ |

更新版本后需要更新密码至少12个字符,我这里是 123456789123456789

第 十四章 Docker容器监控重量级 CAdivsor+InfluxDB+Granfana·

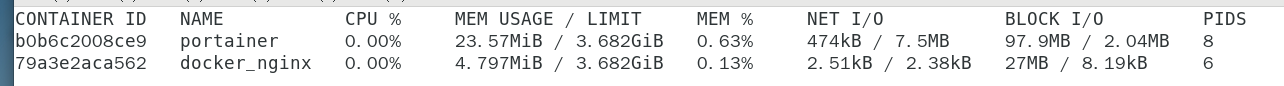

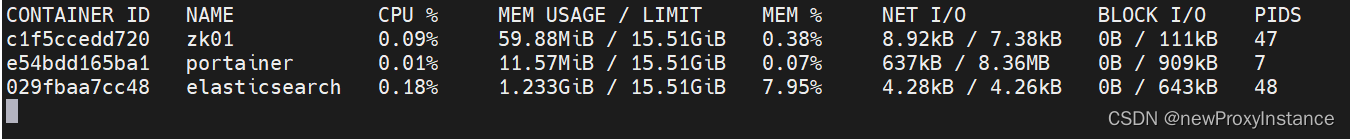

docker stats·

docker stats

CIG介绍·

由于 docker stats 过于简单,所以引入 cig来强化监控。

企业上云之容器监控利器-cAvisor InfluxDB(时序数据库),常用的一种使用场景:监控数据统计 influxDB官网可视化监控指标展示工具-Grafana https://grafana.com/

使用compose编排 CIG·

编写文件 docker-compose.yml

1 | version: "3.1" |

执行检查命令

1 | docker-compose config -q |

执行启动命令

1 | docker-compose up |

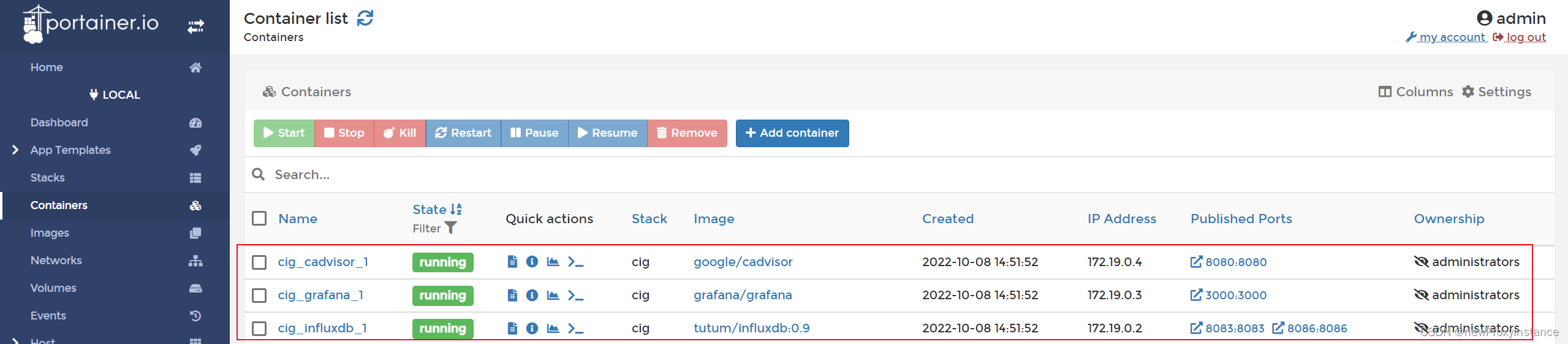

使用portainer查看启动状态

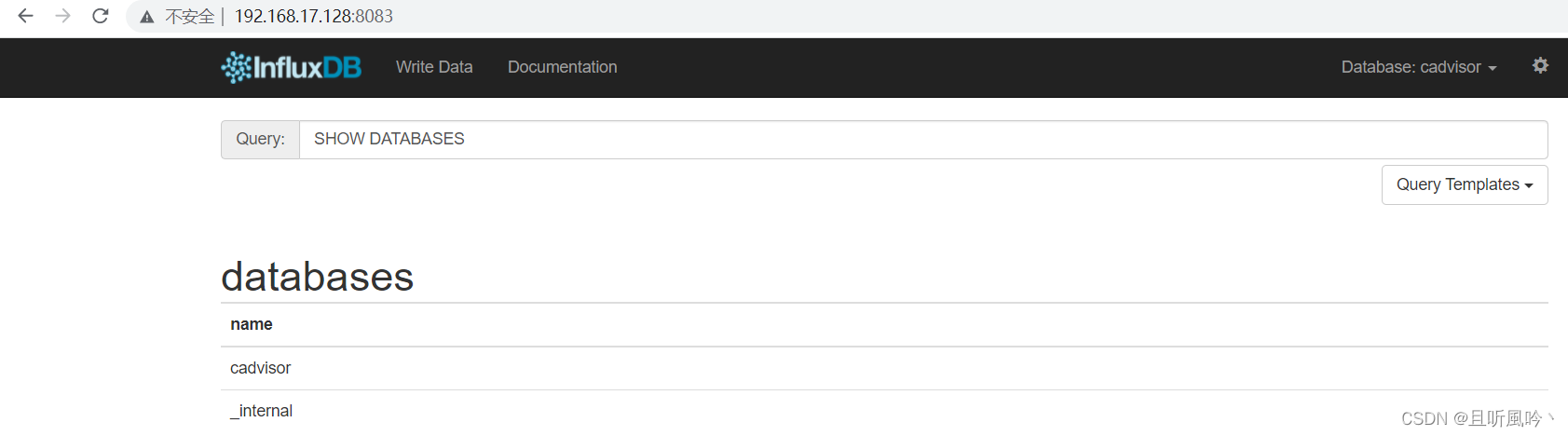

8083 influxdb

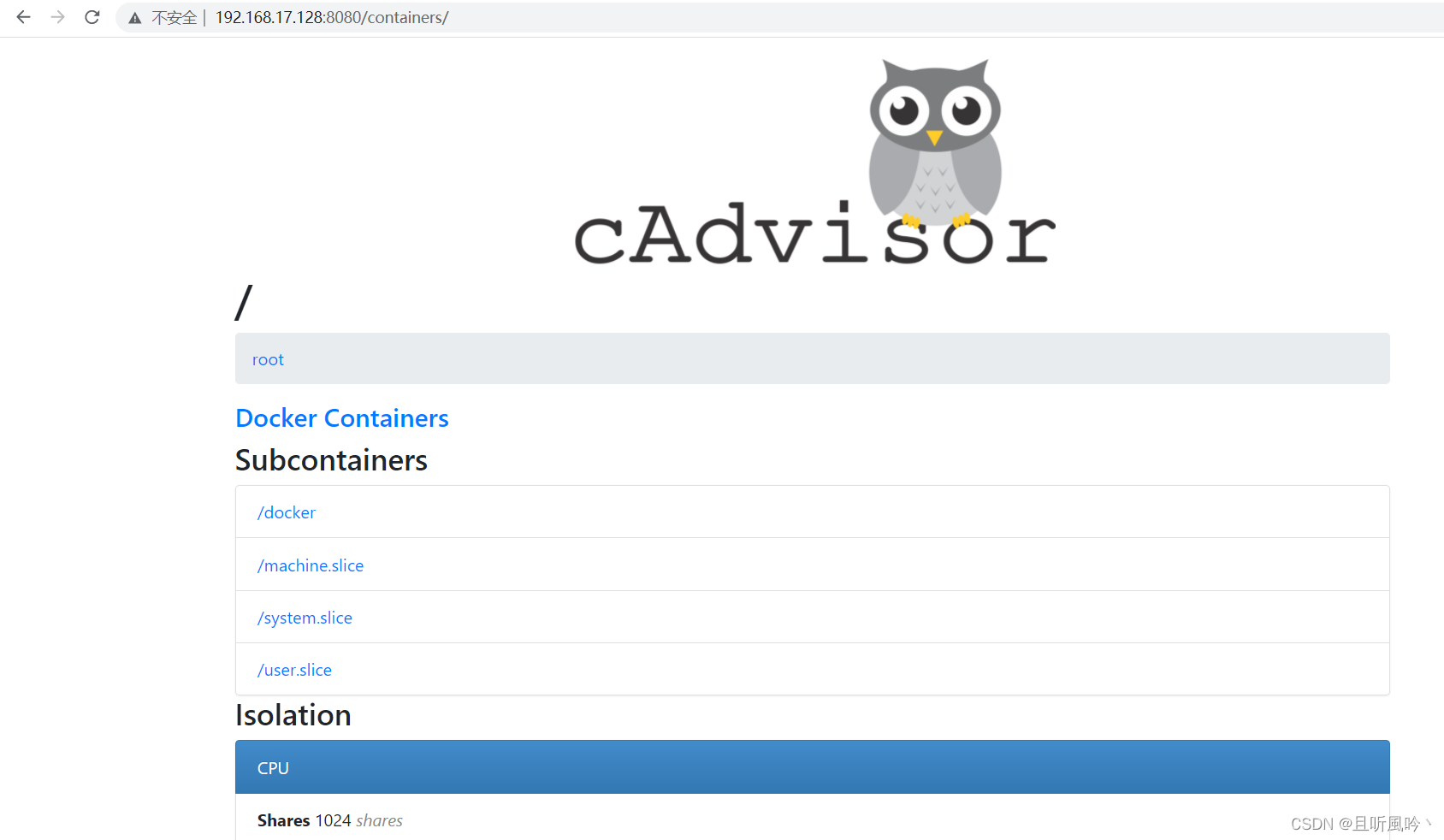

8080 cadvisor

3000 grafana 默认账号密码 admin/admin

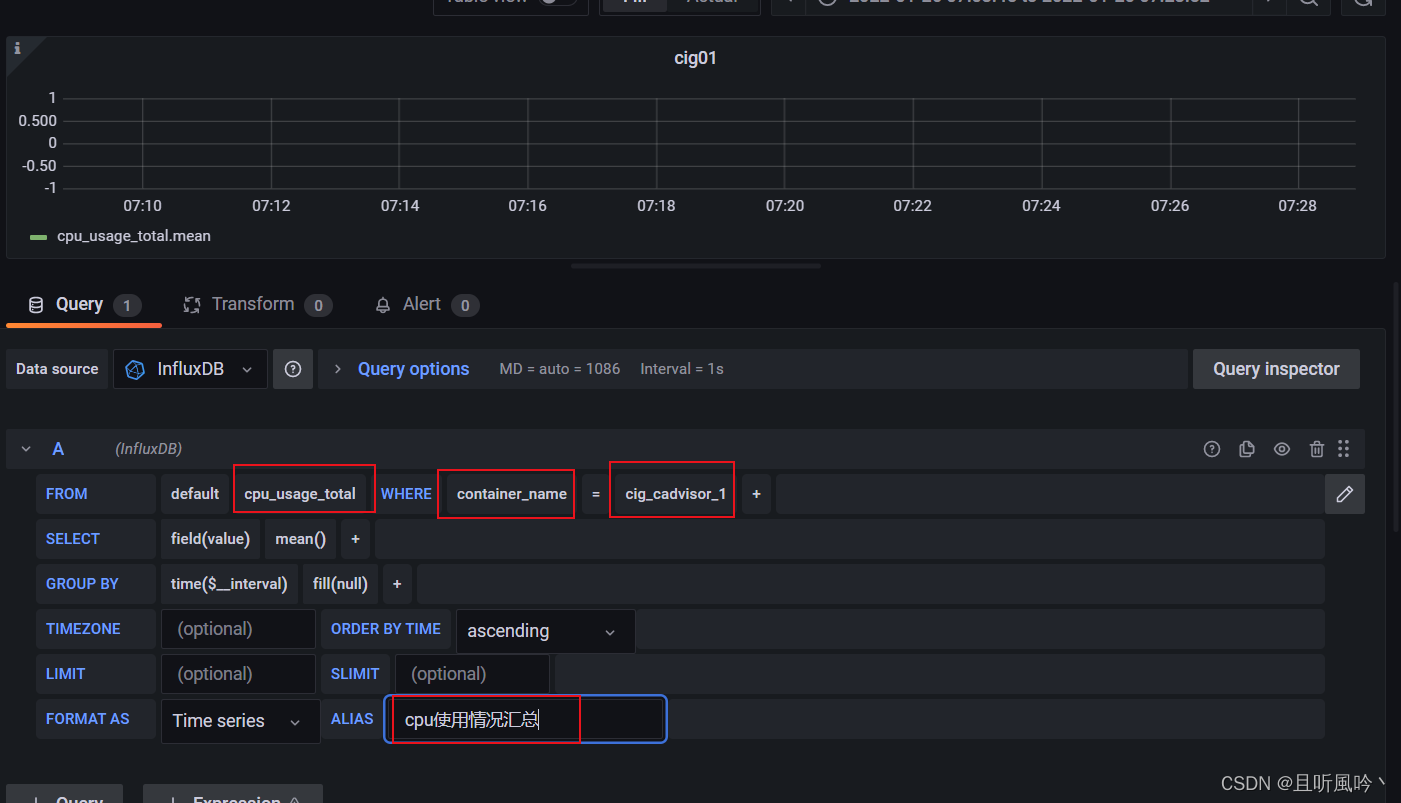

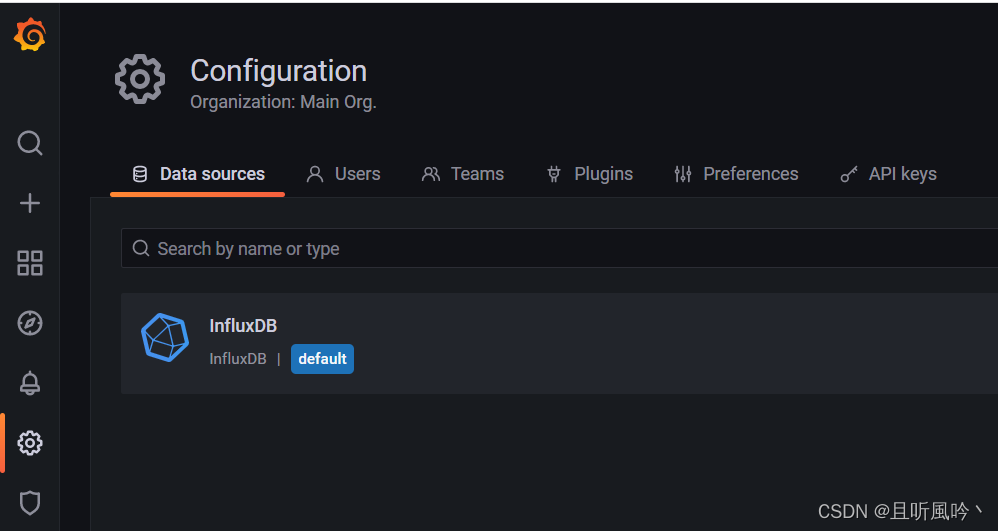

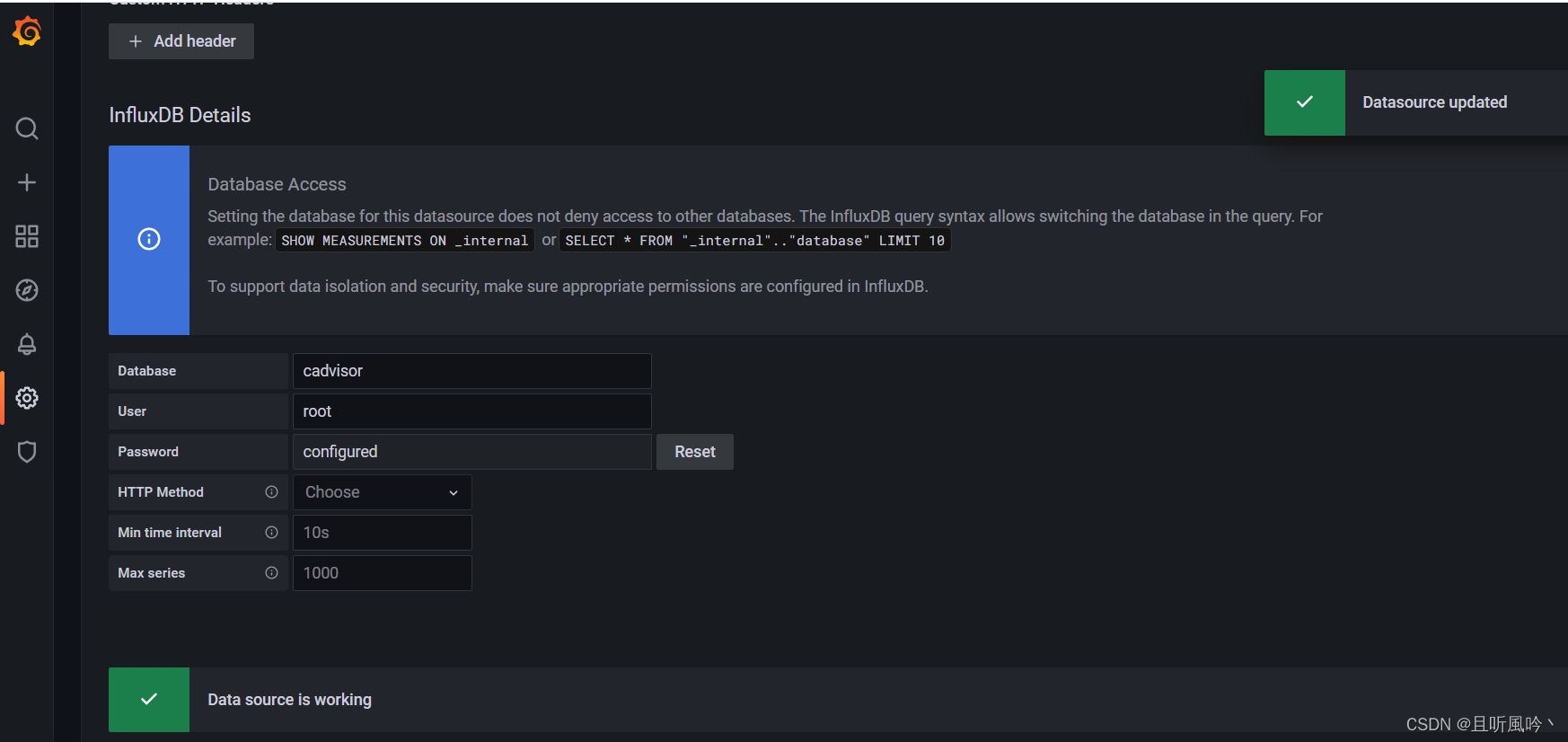

配置grafana数据源

保存并测试

添加面板

配置完成后面板如图所示